Tag: cloud computing

My cloud rules…

Enige tijd geleden, tijdens een verhitte Twitter conversatie tussen cloud guru’s en evangelisten, stelde ik mijn lijst met cloud regels op. Aangezien Twitter nogal ongenuanceerd is met een beperkt aantal karakters volgt hier een samenvatting met wat tekst en uitleg:

Regel 7

Er is veel discussie over cloud definities. Wat is nu wel en wat is nu niet cloud ? De meest gebruikte definitie is die van NIST (pdf).

Echter kijkend naar de ontwikkelingen in de markt en de volwassenheid van de oplossingen , ga ik echter een stapje verder: een generieke definitie van cloud is op dit moment niet relevant.

De scope van o.a. de NIST definitie is op dit moment al erg breed. Met alle ontwikkelingen die er nog komen, zullen we de definitie steeds moeten aanpassen. Over een paar jaar zullen veel van deze ontwikkelingen zo gewoon zijn voor ons dagelijks IT gebruik, dat we het niet meer cloud zullen noemen. Daar waar een ‘definitie’ voor cloud wel van toepassing is, is binnen je eigen organisatie. Dat bevorderd de communicatie tussen bijvoorbeeld IT en de business.

De inhoud van die definitie is opzicht niet eens zo heel relevant, als je maar iets gezamenlijks afspreekt.

Tussen jou en alle leveranciers… tja, daar ga je gedurende de hele cloud hype fase nooit uitkomen. Zodra we in Gartners "Trough of Disillusionment" komen zullen alle marketing afdelingen snel afscheid willen nemen van de cloud term.

Om met de woorden van Simon Wardley te eindigen: Cloud; It’s like computers on the internet, innit?!?

Regel 6

Voordat je cloud computing gaat inzetten als middel, dien je een exit strategie te formuleren. Bij de meeste cloud oplossingen maak je jezelf enigszins afhankelijk van een leverancier of een technologie. Dit is soms omdat er data opslag plaats vind bij de leverancier of wegens het afstemmen van je architectuur of ontwerpen op die van de leverancier.

Je dient dus een plan te hebben om afscheid te kunnen nemen van de cloud leverancier. “Hoe krijg ik mijn data terug?” bijvoorbeeld.

Regel 5

Diverse nieuwe applicatie frameworks geven de mogelijkheid om applicaties te ontwikkelen die minder gevoelig zijn voor de variabele performance van het basis netwerk dat ‘het internet’ heet. Dit is nodig omdat de gebruiker van de applicatie soms de functionaliteit via een mobiele internet verbinding gebruikt en dan weer via een ADSL2 verbinding. Daarnaast levert de manier waar op het internet technisch is uitgelegd altijd variabele performance. De nieuwe technologische mogelijkheden zorgen er voor dat men zich minder druk hoeft te maken over latency. (denk aan video streaming zoals Netflix doet)

Zie ook: http://jwiersma.wordpress.com/2011/01/08/paas-de-toekomst-van-programmeren-1/

Regel 4

Bij het bouwen van cloud applicaties dient men rekening te houden met uitval van software, delen van hardware, complete servers en zelfs complete datacentra. Dit betekend bijvoorbeeld op een juiste manier om gaan met state en stateless.

De nieuwe applicatie framewerken en vooral de PAAS oplossingen die geboden worden, hebben hier voor diverse standaard mogelijkheden.

Zie: http://jwiersma.wordpress.com/2011/01/08/paas-de-toekomst-van-programmeren-1/

Regel 3

Veel IT-ers stappen de cloud wereld in met het idee dat ze hun gedachtegoed, ontwerpen en applicaties zo mee kunnen mee nemen en ‘in de cloud kunnen gooien’. Zo werkt dat echt niet.

Om goed in een cloud omgeving van een leverancier te kunnen werken moet je hun architectuur en ontwerpen goed begrijpen en kunnen toepassen.

Zie:

http://jwiersma.wordpress.com/2011/02/21/mijn-cloud-is-beter-dan-die-van-jou/

http://jwiersma.wordpress.com/2011/04/22/mestvorkknuppels-uit-de-stal-de-cloud-is-down/

Regel 2

Cloud geeft de mogelijkheid om functionaliteit die uitermate gestandaardiseerd is (commodity IT) buiten de organisatie te plaatsen en je te concentreren op zaken die je een voordeel geven op de concurrentie.

Zo levert het hebben van een tekstverwerker of een spreadsheet programma al lang geen voordeel meer op; de concurrentie kan deze ook gewoon kopen en implementeren. De vraag is dus hoeveel geld je moet uitgeven om deze functionaliteit in eigen huis te ontwikkelen en beheren.

Zie:

http://jwiersma.wordpress.com/2010/11/06/en-dan-die-applicatie-naar-de-cloud-toe/

http://jwiersma.wordpress.com/2011/01/31/de-nieuwe-overheid-i-strategie-cloud/ (laatste paragraaf)

Regel 1

Cloud is vooral voor en door de eindgebruiker. Daarbij moet de IT-er vooral de organisatie helpen in te transitie. Een afwerende houding op dat vlak zal cloud computing niet buiten te deur houden en zal de eindgebruiker naar Schaduw-IT drijven.

Deze regel is beschreven in ‘de opkomst van Schaduw-IT’: http://jwiersma.wordpress.com/2011/07/06/de-opkomst-van-schaduw-it/

Dat cloud gedoe… kost mij mijn baan…

Als het om cloud computing gaat zijn vaak (enterprise) IT-ers er als de kippen bij om me te vertellen dat het allemaal toch niet gaat werken, onveilig en onstabiel is. Ik heb vaak grotere discussies met mijn IT vakbroeders dan met de business zijde van de organisatie.

Als het om cloud computing gaat zijn vaak (enterprise) IT-ers er als de kippen bij om me te vertellen dat het allemaal toch niet gaat werken, onveilig en onstabiel is. Ik heb vaak grotere discussies met mijn IT vakbroeders dan met de business zijde van de organisatie.

In een recente discussie over de implementatie van cloud computing bromde een IT-er: “dat cloud gedoe… dat kost me nog eens mijn baan…”.

Als je sommige berichten (en marketing) rond cloud mag geloven, heeft hij gelijk. ‘Zet al je IT maar buiten de deur en in de cloud… en je leven word een stuk beter’, lijken deze verhalen te zeggen. Daarbij ‘gaan de kosten flink omlaag, want je hebt geen IT-er meer nodig’.

Als je jaren hebt gewerkt aan de implementatie van een stuk infrastructuur en de optimalisatie daar van, en er komt nu een leverancier langs die met het bovenstaande je levenswerk afdoet als een hobby project… ja, dan zou ik ook boos worden.

Zoals altijd ligt de echte waarheid ergens in het midden. Een kleine voorspelling hoe het de komende jaren gaat uitspelen:

- Kleine en startende ondernemingen zullen standaard kiezen voor cloud services en niet meer voor eigen (small business) servers in de meterkast.

- Grotere ondernemingen starten met experimenteren met cloud computing. Als eerste zullen hier de SAAS en IAAS services getest worden omdat hier de meeste standaard (commodity) services te vinden zijn. Ook zullen (net als met de start van Virtualisatie) als eerste OTA diensten naar de cloud gaan.

- De snelheid van de migratie zal per sector verschillen en waarschijnlijk ook per land of wereld deel. Dit zal voornamelijk samenhangen met wetgeving en voor die sector geldende regels.

- Daar waar services niet naar de cloud kunnen, zullen steeds meer CIO’s kiezen voor ‘cloud-in-a-box’ diensten. Daarbij word een bepaalde service, volledig extern beheerd, in het eigen datacenter geplaatst. IAAS services zullen als eerste geschikt zijn voor dit soort modellen.

- ICT-Innovatie zal in een hoger tempo nieuwe services en oplossingen leveren. Cloud is hier een motor voor. Veel van die ontwikkelingen zullen ook uit de labs van de cloud services providers zelf komen. Zie: De Formule 1 van ICT.

Dit alles betekend nogal wat voor de ICT-er van nu. Al eerder gaf ik een beschrijving van de impact die PAAS op mijn collega software ontwikkelaars kan hebben. IAAS heeft een mogelijk nog grotere impact op de IT infrastructuur ontwikkelaars en beheerders.

Dit alles betekend nogal wat voor de ICT-er van nu. Al eerder gaf ik een beschrijving van de impact die PAAS op mijn collega software ontwikkelaars kan hebben. IAAS heeft een mogelijk nog grotere impact op de IT infrastructuur ontwikkelaars en beheerders.

Sommige mensen zien alle veranderingen als een kans en andere als een bedreiging. Feit is echter dat ICT altijd een snel veranderd vakgebied is geweest en zal blijven;

In het begin van mijn ICT carrière begon ik met Windows NT 3.51 aan de workstation kant en Novell NetWare 3.12. Binnen enkele jaren en vele uren aan zelf/avond studie had ik mezelf voorzien van certificaten van Certified Novell Administrator (CNA) tot tig examens verder MCNE. Ik kende werkelijk bijna elk commando uit mijn hoofd met volledige opties en wist blind te navigeren binnen bepaalde menu’s.

Allemaal kennis waar ik 10 jaar later niets meer aan heb… Verandering is de enige constante in het ICT vakgebied.

Nieuwe kansen.

Zolang je bereid bent te veranderen en bijscholen en te gaan voor nieuwe uitdagingen, zijn er een hoop kansen:

- Krapte op de arbeidsmarkt; In de komende jaren zullen de baby-boomers met pensioen gaan. Dit geeft mijn generatie de last voor het ophoesten van de pensioen premies, maar geeft ook een hoop krapte op de arbeidsmarkt. Al die mensen die nodig zijn om de cloud services te bouwen, onderhouden en adviseren moeten tenslotte ergens vandaan komen.

- Jevons paradox; Zoals ik in een eerder blog al beschreef zorgen de dalende kosten voor opslag en rekenkracht voor een stijgende vraag. Sommige cloud services groeien op dit moment al met 1000-en fysieke servers per maand en deze vraag zal nog explosief blijven groeien. Dit moet allemaal gebouwd en beheerd worden.

- Onopgeloste puzzels; Voor ons ICT-ers zijn er nog een hoop onopgeloste uitdagingen. Denk aan het goed kunnen verwerken en beschikbaar maken van grote hoeveelheden data bijvoorbeeld. Dit zijn technologische problemen waarbij we slechts aan de vooravond staan van de oplossing. Zeker hoger in de ICT-stack (of OSI lagen) zijn er nog voldoende uitdagingen te vinden.

In de komende jaren zullen bepaalde banen verdwijnen en zullen er nieuwe ontstaan. Aan de cloud aanbieders kant zal een vraag ontstaan naar mensen die grootschalige, multitendant, infrastructuren kunnen ontwerpen, bouwen en onderhouden. Hierbij zal expertise worden gezocht in parallel processing, virtualisatie, energie management en koeling, security en encryptie, high-speed netwerken en data caching (CDN) en gerelateerde vakgebieden. Daarnaast zal veel software moeten worden herschreven om (efficiënt) te kunnen werken op een cloud platform.

Aan de eindgebruikers kant zal, nu we de transitie maken naar een utility en services model, de vraag naar IT-ers voor het bouwen en onderhouden van in-huis systemen zien afnemen. De vraag naar kennis en skills rond informatie management, proces ontwerp en automation zullen echter toenemen. Er zullen ook nieuwe IT rollen ontstaan. Een ‘(cloud) services broker’ zou een rol kunnen zijn waarbij deze persoon de brug vormt tussen (externe) cloud services en de interne business units. Dit zullen steeds meer regie functies worden. Binnen bedrijven die op dit moment een agressief cloud adoptie beleid toepassen, is die wijziging binnen hun IT afdelingen al te zien; de grote van de IT afdeling neemt af, maar de meer senioren en strategische rollen nemen toe.

Aan beide zijde (cloud aanbieder en afnemer) zal de vraag toenemen voor IT-ers die over de traditionele silo’s heen kunnen denken en ontwerpen. Dit is terug te zien aan de opkomst van DevOps aan de cloud provider kant en de vraag naar cloud/services architecten aan de afnemer kant. Deze vaardigheid, om relaties tussen diverse IT disciplines te kunnen onderscheiden en bouwen, is iets wat ontstaat uit het werken en ervaring op doen in verschillende rollen gedurende je carrière. Met de naderende krapte op de markt, zal er flink gevochten worden om dit senioren ontwerpers/architecten. Zoals Gartner analist Dave Cappuccio opmerkte:

…sit back and think about the most valuable people in the IT organization — those people who always get the projects handed to them, because we know they’ll get things done, regardless. If you look at the strengths they bring to any project, it’s rarely depth of knowledge (the vertical T), but breadth of understanding (all the linkages). Drill-down specialists are available in all disciplines, but the linkag

e masters are hard to find.

(Het gehanteerde T-profiel word ook beschreven in het uitstekende boek: “Leidinggeven aan professionals? Niet doen!” van Mathieu Weggeman.)

Dit alles schetst dus juist een rooskleurig beeld voor de IT-er. Veel kansen om met nieuwe technologie aan de slag te kunnen in omgevingen die groter zijn en worden dan ooit. Het betekend echter wel dat er flink gewerkt moet worden aan het verweven van de juiste skill-sets.

Neem afscheid van het Iejoor complex

Zoals Mike Manos recent aan gaf, hebben veel datacenter managers (en IT-ers) last van het Iejoor complex en gedragen zich als die ‘sombere knuffelezel’ (3:43), als het gaat om cloud computing:

Dus tijd voor actie en tijd om de kansen te pakken:

Meer Cloud en werk:

Mestvork&knuppels uit de stal… de ‘cloud’ is down!

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

“A networking event early this morning triggered a large amount of re-mirroring of EBS volumes in US-EAST-1,” Amazon said in a status update just before 9 am Pacific time. “This re-mirroring created a shortage of capacity in one of the US-EAST-1 Availability Zones, which impacted new EBS volume creation as well as the pace with which we could re-mirror and recover affected EBS volumes. Additionally, one of our internal control planes for EBS has become inundated such that it’s difficult to create new EBS volumes and EBS backed instances.

De verstoring kwam kort gezegd neer op de uitval van 1 van de Amerikaanse beschikbaarheids zones. De overige zones draaide wel gewoon door. Als gevolg hier van waren ook enkele andere ‘cloud’ services (voornamelijk SAAS), die boven op AWS gebouwd zijn, uitgevallen. Een lijst hier van werd gepubliceerd op http://ec2disabled.com/

Al snel zagen we dat de cloud tegenstanders de mestvorken en knuppels uit de stal hadden gehaald… want ‘de cloud’ had eindelijk zijn ware aard laten zien… en had gefaald.

Dit gebeurde al eerder, zoals mijn DatacenterPulse collega Tim Crawford in zijn blog aanhaalt:

- Oct 14, 2009 Microsoft Sidekick Data Loss

- Jun 29, 2009 Rackspace Data Center Outage

- May 14, 2009 Google Outage

- Mar 21, 2009 Carbonite Storage Failure

Ook bij deze uitval stonden mensen op de barricade te schreeuwen dat cloud niet betrouwbaar was. Voor leveranciers (en ICT-ers) waar voor de cloud ontwikkeling een bedreiging is (reëel of niet..), is dit een uitstekende gelegenheid om weer wat FUD rond te strooien. Deze tactiek haalde ik al eerder aan in mijn blog: Controle en Vertrouwen; sleutels voor cloud. Hierbij gaf ik ook aan dat het vertrouwen gemakkelijk geschaad word:

Het vertrouwen in cloud computing is iets wat gemakkelijk te schenden is. Het traditionele datacenter leeft redelijk ‘onder de radar’ als het gaat om uitval. Meestal raakt uitval daar slechts enkele applicaties of een deel van de business. Deze uitval kan wel degelijk een grote impact hebben op de productiviteit van een organisatie maar het zal nooit de mate van negatieve publiciteit krijgen die cloud providers ontvangen.

Een vliegtuig crash komt wel in het nieuws, maar de 1000-en auto ongelukken die zelfde dag meestal niet.

Opvallend was echter ook dat een aantal andere cloud services, waar van bekend is dat ze op AWS draaien, gewoon in de lucht waren. Grootste voorbeelden waren Netflix en Twilio.

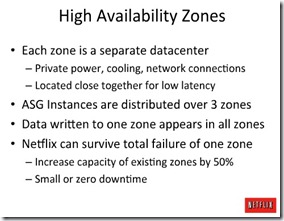

Referentie architectuur…

In voorgaande blogs gaf ik ook al aan, dat cloud adoptie en migratie draait om de adoptie van een referentie architectuur van iemand ander. Je gaat aan de slag op een IAAS of PAAS omgeving die door iemand anders ontworpen en gebouwd is. Dit men hun visie en gedachte goed. Je moet je dus aan hun regels houden;

Het begrijpen van de referentie architectuur en ontwerp principes van je cloud leverancier is bijzonder belangrijk. Zowel bij IAAS, als bij PAAS geld dat je applicatie of omgeving ontworpen moet zijn voor deel-systeem uitval. Zoals in de PAAS serie aangegeven: ‘Cloud applications assume failure.’ Soms word dit ondervangen door de aangeboden frameworks, maar je moet dan wel begrijpen hoe deze werken.

Organisaties die niet geraakt werden door de AWS uitval begrepen de architectuur optimaal en hadden hun diensten bij ontwerp en bouw al verdeeld over meerdere geografische beschikbaarheids zones, zoals NetFlix in een presentatie (slide 32-35) eerder liet zien:

Verder zijn er diverse andere mogelijkheden om redundantie in te bouwen in een AWS omgeving. Zie diverse blogs met tips:

- Why Twilio Wasn’t Affected by Today’s AWS Issues

- Cloud Outages, Redundancy, and Unicorns

- Amazon Outage Concerns Are Overblown

- How to work around Amazon EC2 outages

Systeem uitval is een dagelijkse realiteit. Rond cloud computing word vaak geroepen dat ‘cloud omgevingen niet kunnen uitvallen’. De realiteit is echter dat cloud infrastructuren ook kunnen uitvallen. Het verschil tussen cloud en traditionele infrastructuur is echter dat cloud nieuwe (technologische) mogelijkheden biedt voor redundantie en het herstarten van de dienstverlening als deze uitval plaats vind.

We moeten dus blijkbaar nog wel leren om gaan met deze nieuwe vormen van beschikbaarheid en disaster recovery (DR) 🙂

Mijn cloud is beter dan die van jou

De laatste tijd zien we steeds meer vergelijkingen tussen diverse cloud providers op duiken. Deze zijn vaak in de vorm van:

- Mijn cloud is sneller dan die van jou

- Mijn cloud is goedkoper dan die van jou

- Of als variatie: ik heb Cloud A met B ‘onafhankelijk’ vergeleken en A is sneller/goedkoper dan B.

De eerste 2 vormen zijn vaak het resultaat van een ijverige marketing afdeling van een cloud provider. De laatste is schijnbaar ‘onafhankelijk’ maar vaak gesponsord door de (marketing afdeling van de) winnaar van de vergelijking.

Het is niet vreemd dat dit soort onderzoeken nu steeds meer opduiken; de markt word steeds volwassener en voller. Cloud providers moeten zich proberen te onderscheiden in deze steeds vollere markt.

Oplossingen die ver zijn gestandaardiseerd en derhalve vaak commodity zijn laten zich uitstekend vergelijken op performance en/of prijs. Denk aan server hardware; een commodity die zijn goed laat vergelijken op performance per $$ of performance per Watt. Ook commodity software zoals een tekstverwerker laat zich goed vergelijken op basis van prijs. De extra features die bepaalde server hardware of een tekstverwerker levert, zijn marginaal en vaak niet erg onderscheidend meer. Cloud oplossingen zijn echter verre van gestandaardiseerd en laten zijn dus slecht onderling vergelijken.

Referentie architectuur

Het leveren van een IT dienst zoals rekenkracht (als bij IAAS) of een programmeer omgeving (als bij PAAS), blijft een complexe bezigheid. Zeker als we kijken naar additionele zaken die nodig zijn om alles te laten werken. Zo is de rekenkracht niets zonder de toegang tot die rekenkracht. Hierbij komen dan zaken zoals DNS en CDN kijken. De programmeer omgeving is niets zonder een framework voor toegang en toegangscontrole (Identitymanagement / access).

De kracht van veel cloud leveringen is het feit dat al deze complexe zaken worden afgehandeld door de cloud leverancier en daar mee de wereld makkelijker bruikbaar gemaakt word voor de afnemer. Zodra we echter naar benchmarks voor snelheid gaan kijken, is het echter wel degelijk van belang hoe deze levering is opgebouwd en hoe of deze op een juiste manier gebruikt word.

De cloud leveranciers leveren hun IT omgeving volgens een bepaalde ontwerp gedachte en visie. Deze is vastgelegd in de referentie architectuur. In deze architectuur staan de kaders en principes die van toepassing zijn op de geboden omgeving. Als men zich niet aan deze kaders houd, dan werkt de omgeving niet of is de performance slecht. Bij het afnemen van een cloud omgeving bij bijvoorbeeld Amazon dient men zich dus wel te houden aan de referentie architectuur.

Dit is extra duidelijk bij de Platform As A Service (PAAS) leveringen. Al eerder gaf ik aan dat een applicatie niet zo maar verplaatst kan worden naar een cloud omgeving. Deze dient vaak aangepast te worden om bijvoorbeeld schaalbaarheid mogelijk te maken. Zodra we een applicatie op een Microsoft Azure omgeving plaatsen of ontwikkelen, dan houden we ons aan de referentie architectuur voor Azure en zorgen we er voor dat deze hier voor geoptimaliseerd word. Dat is niet anders dan op dit moment in een traditionele IT omgeving ook gedaan word. Dit alles maakt het creëren en draaien van benchmarks wel erg lastig. Een test applicatie op Azure kan bagger traag werken op een Google AppEngine omdat deze zich niet aan de spelregels (architectuur) van Google houd en er zeker niet voor geoptimaliseerd is. Dit alles is ook van toepassing op de vergelijkingen die ik rond IAAS leveringen voorbij zie komen op dit moment waarbij CloudHarmony op dit moment de beste poging tot vergelijking van cloud providers doet.

Daarnaast moet men benchmark publicaties met een flinke korrel zout nemen, zoals ik aangaf in ‘Waar benchmarks zijn… wordt vals gespeeld…’

Performance of feature ?

Naast de referentie architectuur, is het belangrijk om te kijken naar de geboden producten en diensten van de cloud leverancier. Hierbij zien we namelijk grote verschillen ontstaan tussen de aanbiedingen op dit moment. De feature set bij Amazon is op dit moment groter dan bij diverse andere aanbieders. Daarnaast bereid Amazon deze set in zeer hoog tempo uit.

Recent schreef Derrick Harris (Gigaom):

It’s arguable that a virtual machine is a virtual machine in the sense that they all provide standard image types and are capable of hosting standard applications, but different classes of users have different requirements for what’s underlying or surrounding their machines. It’s very easy to see why some developers would prefer the breadth of capabilities afforded them by choosing AWS

De beschikbare benchmarks moeten dus duidelijk niet leidend zijn in de keuze voor een cloud provider. Veel belangrijker is het om te kijken of de referentie architectuur en onderliggende producten en diensten passen bij jou wensen. Het geheel van deze diensten beïnvloed namelijk ook nog eens de TCO voor het gebruik er van. In de diverse vergelijkingen rond kosten word dit vaak vergeten als men enkel de pay-per-use bekijkt.

Als je je committeert aan de kaders van de cloud leverancier, de omgeving gebruikt waar voor hij bedoeld is en je je ontwikkeling optimaliseert voor het gebruik van deze cloud omgeving kun je een zeer gelukkig ‘cloud leven’ leiden zoals bijvoorbeeld Netflix.

En als je dan toch een vergelijking/benchmark bekijkt: kijk dan goed of het appels-met-appels is en geen appels-met-peren.

Meer vergelijking:

De Formule 1 van de ICT…

In 2008 hield ik op AFCOM’s DatacenterWorld in Las Vegas een presentatie over datacenter consolidatie. Ik had de mogelijkheid om de keynote van dit congres bij te wonen, die gegeven werd door Michael Manos (toen nog Microsoft, nu Nokia). Dit was de presentatie waar in Microsoft bekend maakte van de traditionele bouw methode af te stappen en in Chicago een container datacenter neer te zetten. Aan het eind van het congres had ik de mogelijkheid om met Manos na te praten. We bespraken de kritieken die in de pers waren verschenen door de traditionele datacenter leveranciers en de manier waar op hij aan dit out-of-the-box concept was gekomen. We zaten beide op het zelfde punt; het werd steeds slechter te verkopen aan het management dat datacenter ontwerp, bouw en oplevering soms jaren in beslag nam en veel geld kosten. Hierna was het in de lucht houden er van ook nog eens heel duur en complex. Daarnaast leverde de refesh/life-cycle en onstuimige groei van de ICT apparatuur, die gebruik moest maken van het datacenter, ook behoorlijk wat problemen op. Er was langzaam aan een onhoudbare situatie aan het ontstaan.

Er werd mij ook snel duidelijk dat Microsoft bezig was met een explosieve groei rond hun eigen ICT infrastructuur. Een infrastructuur die in hun meeste datacentra een groei van 10.000 servers per maand kende. Als ik om mij heen keek in Enterprise ICT omgevingen zag ik daar ook een behoorlijke groei, maar vooral een groei in complexiteit. Applicaties kennen veel relaties onderling, maar ook relaties met de onderliggende infrastructuur. Er zijn relaties tussen de hardware en software en ga zo maar door.

Toen ik eind 2008 een kijkje achter de schermen kreeg bij Microsoft’s San Antonio datacenter, werd ik geprikkeld door de vraag: “hoe kunnen ze zo’n massale infrastructuur met zo weinig inspanningen uitbreiden en beheren ?”

Uiteraard word er in ICT land meteen geroepen dat dit te maken heeft met het leveren van specifieke diensten; een enterprise IT omgeving dient tientallen diensten en honderden applicaties te ondersteunen, waar een web service leverancier zich kan toeleggen op 1 specifieke levering. Dat argument gaat voor sommige grote cloud leveranciers wel op, maar niet voor allemaal. Microsoft heeft in zijn omgeving Search, BPOS, Hotmail en enkele tientallen andere diensten met allemaal hun eigen IT profiel en karakteristiek. Google heeft dat ook, denk aan Google Apps maar ook Google Voice.

Het andere argument is de schaalgrote. Echter deze zou juist moeten leiden tot zalen vol met ICT beheerders om de boel in de lucht te krijgen en te houden.

Mijn contacten vanuit DatacenterPulse hebben het mogelijk gemaakt dat ik de afgelopen 2 jaar veel kijkjes ‘achter de schermen’ heb mogen nemen en met de engineers en ontwerpers heb kunnen praten van bedrijven zoals eBay, Google, Amazon, Facebook en Microsoft.

Het aardige is dat deze grote IT cloud providers op dit moment de Formule 1 van de ICT wereld vormen. Bij de Formule 1 in de autobranche rijden auto’s en techniek rond die niet betaalbaar is voor de gemiddelde man/vrouw. Uiteindelijk beland er toch technologie die ontwikkeld is in de Formule 1 in de auto’s voor dagelijks gebruik. Zo loopt het ook in de ‘Formule 1 van ICT’; technologie en innovatie die nu bij Microsoft, Google of Amazon word ontwikkeld en gebruikt voor hun eigen basis infrastructuur, is niet direct toepasbaar binnen enterprise IT omgevingen en zeker niet het MKB. We zien echter in het afgelopen jaar al wel technologie door sijpelen naar deze omgevingen.

Een hoop ICT-ers denken echter dat dit alles wel aan hun voorbij gaat. Het is een hype, dus waait wel over. Het aardige is echter dat hun traditionele leveranciers op dit moment wel volop beïnvloed worden door deze beweging.

Deze beweging word gedreven door je eigen CIO/CTO. Als deze kijken naar in-huis ICT dienst verlening rond kosten, efficiëntie van inzet, elasticiteit en schaalbaarheid en dat dan vergelijken met de aanbiedingen en beloftes van uit de cloud… dan gaan ze vanzelf roepen dat ze die cloud voordelen ook willen. Dit moet dan echter wel mogelijk zijn vanuit de interne IT omgeving (private cloud) omdat er, logischerwijs, nog wat koud water vrees is om maar alles buiten de deur in een cloud te zetten.

Dit is dus de vraag waar alle traditionele ICT leveranciers in springen. Die kijken hierbij ook naar de manier waar op de grote cloud jongens dit hebben gedaan. Daarnaast springen ook een hoop opensource leveranciers op deze private cloud trein (Ubuntu, OpenStack, etc..).

Hier mee word de private cloud omgeving een Self-fulfilling prophecy.

We hebben op dit vlak slechts het begin gezien met Oracle’s Exalogic, Cisco/EMC’s vBlock, etc.. Al deze bewegingen zijn gericht op het verkrijgen en behouden van markt aandeel in deze turbulente markt. Op het grensvlak tussen private en public cq intern/extern cloud levering zien we dit gevecht ook met API’s. Leveranciers proberen de klanten in te sluiten door een gesloten omgeving te creëren.

Dit alles maakt het lastig om goede leveranciers en technologie keuzes te maken.

Een recente investeerders blik op de ICT markt stelt zich echter de vraag of de ICT reuzen als HP, IBM en Oracle het wel gaan overleven met de huidige strategie;

In the very near term, companies will continue to invest in their own private cloud-computer systems. That will benefit the traditional tech behemoths that sell servers, storage, personal computers and business software, such as IBM (IBM); HP; Dell; Oracle and Cisco. But the markets already are starting to make longer term distinctions. With the exception of IBM, these stocks have been trading at depressed valuations because they are mature companies, says Paul Wick, technology-portfolio manager at Seligman Investments.

And the clock is ticking for the current giants. The ultimate “public-cloud” model is analogous to power utilities, where computing power would be sold based on usage and need.

Gartner worstelt ook met die vraag;

Smith noted that the companies seen today as enterprise computing leaders, such as SAP and Oracle, aren’t seen as cloud computing leaders; and cloud leaders, such as Amazon, Salesforce, and Google, aren’t seen as enterprise leaders. Over time, they say this will change.

In their view, the cloud computing continuum moves from closed private cloud implementations to full open public ones, with lots of things in between, which include managed private clouds, virtual private clouds, and community private clouds (shared by a few companies).

Het mag duidelijk zijn dat de hele cloud ‘hype’ nogal wat los heeft gemaakt in ICT land. Enterprise IT kan zich niet aan deze ontwikkeling onttrekken, hoe graag sommige dat ook zouden willen. Voor de techneuten is het zaak om goed de Formule 1 van ICT in de gaten de houden en de juiste technologie en methode te ontdekken die toepasbaar is voor de eigen organisatie. Voor het ICT management is het belangrijk om de eigen ICT organisatie voor te breiden met beleid en strategie, op de storm die komen gaat… de donkere wolken pakken zich samen; cloud storm op komst !

Meer Cloud? zie: Whitepapers voor een strategie richting.

Zie ook: Gartner: Will Microsoft and VMware Dominate the Cloud Landscape?

en: