Nu echt modulair…

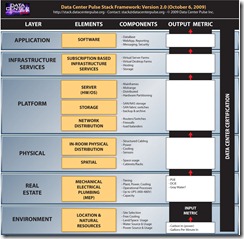

Een datacenter bouwen als Lego blokjes… dat lijkt de utopie in de modulaire datacenter wereld. In deze wereld is het datacenter gebouwd uit verschillende blokjes met de volgende karakteristieken:

- De blokjes zijn beschikbaar in verschillende soorten en maten

- De blokjes zijn snel leverbaar, hier door is het datacenter snel uit te bereiden (+/- 6 weken, JIT levering)

- Bij de keuze van het blokje, kan men kiezen uit TIER 1 t/m 4 voor beschikbaarheid. Hier door kan men beschikbaarheidsniveaus mixen.

- Bij de keuze van het blokje, kan men kiezen uit diverse PUE niveaus.

- Bij de keuze van het blokje, kan men kiezen uit diverse warmte belastingen per rack (kW/rack).

- Bij de keuze van het blokje, kan men keizen uit diverse koeloplossingen (lucht (van buiten), water)

- Bij de keuze van het blokje, kan men kiezen uit huur, lease of koop van het blokje.

Hier mee kan men dus op het juiste moment, het meest geschikte blokje inzetten tegen de juiste financiële voorwaarde. Deze modulariteit is niet automatisch een container datacenter. Diverse ‘niet-container-leveranciers’ leveren ook een modulair gebouwde oplossing.

Deze utopie is al langer de wens van menig datacenter eigenaar. Uiteraard proberen diverse leveranciers in te spelen op deze wens. Modulariteit is hier mee tot een marketing term verworden, die te pas en te onpas vermeld word bij diverse datacenter oplossingen.

Zoals Lex Coors (Interxion), terecht, zich beklaagd in DatacenterWorks:

Tegenwoordig lijkt het wel alsof alle datacenters modulair worden gebouwd. Helaas verstaat niet iedereen hetzelfde onder modulair bouwen, zo stelt Lex Coors, vicepresident datacenter technologie en engineering group van Interxion. “Er wordt veel gesproken over modulair bouwen maar uiteindelijk zie ik alleen de fasering terug en niet de modulaire benadering van de infrastructuur.”

Datacenter Pulse toetst regelmatig binnen de 1500+ leden wat hun top 10 grootste uitdagingen zijn op datacenter gebied. Op nummer 9 vinden we daar ook modulariteit:

More Products with Modularity

Goal: Enable pro-active, simple expansion or contraction of datacenter capacity without risk or reduction of design availabilities.

- Update: Not seeing any significant increase in modular product offerings or end user implementations

- Both vendors and end users need to elevate the discussions to implement current modular solutions to enable future modular products.

De frustratie van Lex word dus gedeeld door andere datacenter eigenaren. Datacenter Pulse komt nu te hulp met de Modulair RFP.