De afgelopen week was er de aankondiging van de nieuwe i-Strategie voor de rijksoverheid, gevolgd door de mededeling dat de overheids-CIO’s dit plan hadden goed gekeurd:

De ict- en informatiestrategie (I-Strategie) van de Rijksoverheid is definitief goedgekeurd door de Interdepartementale Commissie van cio’s (ICCIO). Dat maakte Rijks-cio Maarten Hillenaar bekend op het Digitaal Bestuur Congres 2011. Als laatste stap wordt de I-Strategie nu aan de Tweede Kamer aangeboden. De strategie heeft betrekking op alle ict-voorzieningen voor de bedrijfsvoering van de Rijksoverheid en op een aantal generieke ict-voorzieningen in het primaire proces.

In het kader van de bezuinigingen en de stap naar een kleinere en efficiëntere rijksoverheid, doet onze Rijks-cio wat hij moet doen en komt met een plan voor de noodzakelijke samenvoeging van ICT voorzieningen.

Uiteraard komt ‘cloud’ ook voorbij in de context van de nieuwe strategie. Er schuilen tenslotte veel voordelen in het gebruik van cloud. Zeker als je alle media om de hype heen mag geloven. Ook andere overheden zoals die van Japan en de USA doen aan ‘cloud’.

Nu moet ik bekennen dat ik de exacte inhoud van de i-Strategie niet ken, dus mijn conclusies moet baseren op artikelen uit de diverse (ICT)media. In deze media zie ik echter steeds het zelfde terug komen;

…De strategie grijpt in op alle ict-voorzieningen voor de bedrijfsvoering van de Rijksoverheid alsmede op een aantal generieke ict-voorzieningen in het primaire proces.

…spreekt Hillenaar over de gesloten Rijksoverheid-Cloud. Met het netwerk en de DWR zijn de voorzieningen er om een Rijks-Cloud in te richten van waaruit allerlei centrale toepassingen kunnen worden gefaciliteerd. Daarbij past ook de consolidatie van de huidige 63 datacenters waarmee het proces van vereenvoudiging en standaardisatie verder wordt doorgezet.

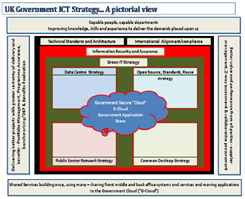

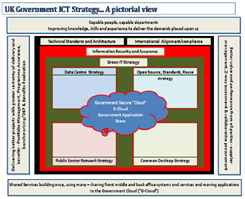

UK G-Cloud

In mijn vorige blog rond overheidscloud schreef ik over de Amerikaanse overheid en de manier waar op zij cloud hebben opgepakt. Een nog betere parallel voor het ICT proces dat nu start bij de Nederlandse overheid, is te vinden bij de Engelse overheid. Eind 2010 sprak ik Mike Truran over de ontwikkeling van de UK G-Cloud.

De gekozen hoofdgebieden uit de UK, komen overeen met die in Nederland:

Al deze onderdelen zien we in de besproken i-Strategie ook weer terug/bij elkaar komen. Het traject in de UK rond G-Cloud is echter al gestart in 2009. De ontwikkeling van de UK strategie is zwaar beïnvloed door de manier waar op Obama dit in de USA heeft aangepakt; “The Obama effect: The US IT Revolution and the UK.” Zo zien we overheids-IT wereldwijd grof weg dezelfde kant op gaan, maar met duidelijke verschillen in de uitvoering en uitwerking er van.

Traditioneel zijn overheden goede klanten van de grote IT ‘System Integrators’ van deze wereld. Dit alles gaat gepaard met mega contracten en aanbestedingen, waar veel kleine organisaties nooit aan zouden kunnen deel nemen. Dit is ook het geval in de UK, waar veel overheids IT is ge-outsourced naar een aantal grote marktpartijen.

Het is dan ook niet vreemd dat deze staan te trappelen om de overheid een ‘cloud’ te verkopen. Zeker met de huidige economische condities lijkt een aanbesteding voor de bouw en migratie van overheids ICT een zeer welkome bron van inkomsten.

Met behoud van hun (financiële) aandeel willen deze huidige dienst verleners dus ook wel mee werken aan de consolidatie van de overheids spulletjes.

HP was er dus ook snel bij om te melden dat ze een demo omgeving hadden voor de UK overheid waarbij ze de G-Cloud konden laten zien.

Ik kan me zo ook voorstellen dat de telefoon van onze Rijks-cio niet stil staat na de aankondiging van de i-Strategie, en de grote IT leveranciers aan de poort staan te trappelen.

In Nederland lijken we dezelfde route te volgen als de UK, waarbij ‘cloud’ staat voor het bij elkaar zetten (consolidatie) van overheids datacentra en IT infrastructuur en op die manier geld te besparen. Dit is een consolidatie slag die diverse grote bedrijven in de afgelopen jaren ook al hebben afgelegd om hun ICT kosten te drukken. De vraag is echter of we dit momentum niet moeten pakken voor echte verandering en vooruitgang.

Volgende stap?

Zoals Peter Hinssen in zijn ‘New Normal’ beschrijft, geeft cloud ons de volgende stap in de IT evolutie:

[youtube=http://www.youtube.com/watch?v=3ugBwy343Ak&w=448&h=252&hd=1]

De vraag is nu welke volgende stap de overheid moet nemen in zijn IT evolutie. De i-Strategie maakt duidelijk dat er iets moet gebeuren en de Rijks-cio ziet kansen, in wat misschien wel het ‘spoetnik moment’ is voor overheids-IT. Tijd om een sprong vooruit te maken dus…

Better… for less (not: buy more servers… and more licences)

Het UK rapport “Better for Less – How to make Government IT deliver savings.” (PBA) geeft een verfrissende kijk op overheids ICT, innovatie en de juiste manier van markt stimulatie. Het evalueerde de strategie van de UK Gov en de bouw van hun G-‘Cloud’. Het keek ook naar de manier waar op de huidige IT ‘System Integrators’ hun dienst verlening inzetten en het feit dat deze bij grote contracten vooral gebaat zijn bij het handhaven van status-quo en niet bij echte innovatie. Rond het gebruik van cloud diensten beschrijft dit rapport:

Government must stop believing it is special and use commodity IT services much more widely. It must make the most of its tremendous institutional memory and experience to make IT work together across government and it must innovate at an entirely different scale and price point.

…

Government applications and services should therefore be available ‘in the cloud’. Not in a cloud, in the cloud, for the reasons discussed above. This requires a fundamental change in the way government procures its infrastructure, which is currently based on providing an inward-facing ”G Cloud”. It also promotes and encourages the development of smaller, iterative applications that can be used by different departments across government,

De door de Nederlandse Rijks-cio aangehaalde “generieke ict-voorzieningen” zijn meestal commodity ICT en derhalve uitstekend geschikt om uit de cloud als SAAS te halen.

Uiteraard laait hierbij het debat over veiligheid altijd weer op. Hier word echter volop op ingespeeld door de leveranciers van SAAS oplossingen. Vele zijn in het bezit van International Organization for Standardization (ISO) 27001, Statement on Auditing Standards (SAS) 70 Type I and Type, PCI-DSS, HIPAA, etc.. Dit zijn vaak meer audit controls dan dat menig IT afdeling van de overheid kan tonen.

Daarnaast leveren sommige SAAS leveranciers een speciale overheids versie, die aan nog meer (overheids) eisen voldoet, zoals Microsoft BPOS Federal (nu Office 365). Hierbij zijn vaak ook garanties af te geven over de locatie van data.

En de rest…

Uiteraard is niet alle ICT binnen de overheid commodity ICT en blijven we vanuit de veiligheid discussie ook data houden die niet gehuisvest kan worden in de public cloud. Hierbij zal sommige data afhankelijk zijn van wetgeving die ons op dit moment beperkt in de mogelijkheden van cloud gebruik.

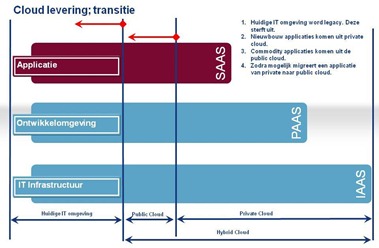

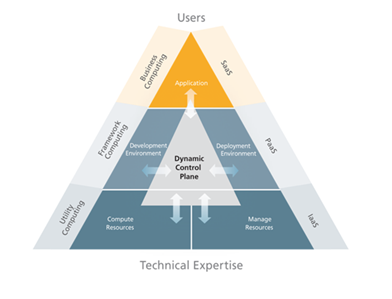

Gelukkige bied het cloud model hier ook kansen in diverse smaken (IAAS, PAAS, SAAS) en soorten (Public, Private). (Zie PAAS artikel, eerste deel).

Het bouwen van een private cloud, is daarbij echt iets anders dan enkel de consolidatie van de huidige ICT voorzieningen. Gezien de schaal van ICT bij de gehele Nederlandse overheid, liggen hier kansen om een cloud omgeving te bouwen op de manier waarop de ‘big boys’ dat doen. Zoals in het eerder geschreven artikel Formule 1 van ICT beschreven moet je voor de bouw van een echte private cloud omgeving goed kijken naar de public cloud leveranciers en de manier waar op zijn in techniek en proces hun IT bedrijven. Hoe meer je daarbij cloud standaarden gebruikt, die in de public cloud ook gebruikt worden, hoe beter de overlevingskansen worden voor je ICT strategie op langere termijn. Zoals Forbes recent melde in een cloud do&don’ts:

Don’t use a private cloud without a migration plan to the public cloud. A variety of vendors have bet the farm on the fact that clouds based on proprietary hardware, meaning anything more expensive than the cheapest commodity technology, will always be more expensive than the public cloud as built by Google and Amazon that relies on the cheapest components.

…private clouds must be built on public cloud standards so that the same management systems can be used. In this way, computing workloads can move easily from your private cloud to the public cloud.

…

Don’t let the cloud happen to you. Remember, the biggest impact that the cloud in any form will have will be when it translates into business value. None of the vendors will ever be able to tell you about how to do this. Their story will always be about cost and abstract “flexibility.”

The winners will be the companies that understand how the cloud makes new offers and products possible.

Het is dus van belang om goed te weten wat er komt kijken bij het bouwen van een private cloud. Dit voorkomt te hoge kosten bij de exploitatie van de private cloud en hoge kosten bij toekomstige migratie naar public cloud.

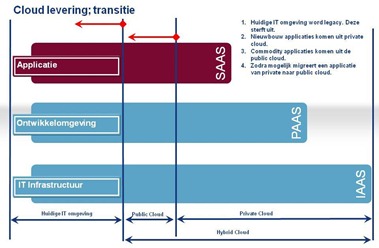

De verdeling van de totale ICT voorziening zal namelijk constant in transitie zijn over de vlakken van public, private, IAAS, PAAS en SAAS: van de huidige ICT, naar meer gebruik van cloud (public&private). Na enige tijd zullen applicaties (en data) uit de private cloud omgeving ook geschikt worden voor een transitie naar de public cloud. Na enige jaren zal de traditionele IT omgeving verdwijnen. De meeste ICT functies zullen uiteindelijk afgenomen worden in de public cloud (80%). Enkele functies zullen nog geleverd worden vanuit de private cloud (20%):

‘Dit gaat even pijn doen’…

De overheid is nooit echt goed geweest in het uitvoeren van hele grote projecten en zeker niet op ICT vlak. Daarnaast zal het best lastig zijn om alle departementen op een lijn te krijgen. ICT hervorming op deze schaal zal ook altijd gepaard gaan met de nodige miljoenen aan investeringen.

Dit zal echter het geval zijn bij elk te kiezen scenario. Zodra we bijvoorbeeld alle departementen gebruik zouden laten maken van 1 (nieuw) datacenter als co-lo omgeving, begint daar de discussie al over niet op elkaar afgestemde beveiligingsmodellen tussen departementen. En dat is co-lo nog de ‘laagste’ vorm van consolidatie.

Ik wil dus niet beweren dat deze transitie naar een ‘overheid & IT 2.0’ makkelijk zal zijn. We bevinden ons in een complexe ICT wereld, waarbij elke migratie pijn zal doen. De vraag is echter of de overheid nu een echte stap vooruit durft te nemen;

- Gebruik van public SAAS voor commodity ICT functionaliteit.

- Gebruik van off-premises private PAAS/IAAS voor overige ICT functionaliteit.

- Gebruik van on-premises private PAAS/IAAS voor gevoelige data en ICT functionaliteit.

Als we dit combineren met stimulatie van innovatie door de markt (zoals in het Better for Less document) en andere manier van applicatie bouw (crowdsourcing), voorzie ik een mooie toekomst voor de overheids ICT en de ‘overheids cloud’.

Bij Asset Management gaat het om het registreren en bijhouden van de componenten die in het datacenter beschikbaar zijn. Denk aan de racks, bekabeling, koeling, energie voorziening, etc.. Hierbij gaat het om de complete levenscyclus van de apparatuur: van aankoop tot afvoer. Over het algemeen worden bij Asset Management de algemene regels en methodes van ITIL gevolgd. Hier zijn hele boeken over geschreven. Tussen al deze componenten kan men de relaties vast leggen. Energie ketens kunnen van hoofdverdeler tot op de server vast gelegd worden en netwerk bekabeling van systeem tot systeem. Door al deze gegevens te combineren kan men ook capaciteitsmanagement in regelen; hoeveel heb ik, hoeveel verbruik ik, hoeveel heb ik nog nodig en wanneer loop ik tegen de grenzen aan? Dit voor rack ruimte (hoogte eenheden of U), beschikbare koeling en/of energie (Watt), aantal beschikbare glas/koper poorten en beschikbare elektra outlets.

Bij Asset Management gaat het om het registreren en bijhouden van de componenten die in het datacenter beschikbaar zijn. Denk aan de racks, bekabeling, koeling, energie voorziening, etc.. Hierbij gaat het om de complete levenscyclus van de apparatuur: van aankoop tot afvoer. Over het algemeen worden bij Asset Management de algemene regels en methodes van ITIL gevolgd. Hier zijn hele boeken over geschreven. Tussen al deze componenten kan men de relaties vast leggen. Energie ketens kunnen van hoofdverdeler tot op de server vast gelegd worden en netwerk bekabeling van systeem tot systeem. Door al deze gegevens te combineren kan men ook capaciteitsmanagement in regelen; hoeveel heb ik, hoeveel verbruik ik, hoeveel heb ik nog nodig en wanneer loop ik tegen de grenzen aan? Dit voor rack ruimte (hoogte eenheden of U), beschikbare koeling en/of energie (Watt), aantal beschikbare glas/koper poorten en beschikbare elektra outlets.