Datacenter Pulse update

Dean en Mark hebben een korte video update uitgebracht met een terugblik op de afgelopen 3 jaar DCP en een vooruitblik:

Meer:

Dean en Mark hebben een korte video update uitgebracht met een terugblik op de afgelopen 3 jaar DCP en een vooruitblik:

Meer:

<sorry Dutchies.. this one is in English… sort of..>

My fellow Datacenter Pulse (DCP) colleague Mark Thiele wrote a good article on the use of PUE in the datacenter industry. He basically argues that you should look at the TCO of the datacenter and have a holistic view (like we promote with the DCP stack)

He opens with the ‘my PUE is better than yours remark’ we see going around in the industry. This is mentioned before by the Green Grid; the misuse of PUE. (I have written several articles about this issue on my Dutch datacenter blog)

Well guess what… we kinda created this monster ourselves;

Commodity

Datacenter are going commodity. Differentiation is in efficiency; looking at all the signs in the datacenter industry: the datacenter is becoming a commodity. The general idea is that any successful product will end up a commodity. See Simon Wardley’s excellent presentations on this subject.

Example signs are:

(got lots more, but for an other blog and beyond the point now…)

Most of this leads to technology being available to everyone. You still need a big budget to start building a datacenter but cost is coming down thanks to advances in IT technology (like: do we still need to build TIER4?) and facility technology. Great example is the option to build modular and from an assembly line. This reduces datacenter production cost and you can spread CAPEX across time.

For any commodity product the competitive advantage diminishes, prices go down and if you’re in the market of selling the stuff: your differentiation is on price and efficiency.

So we push towards efficiency and lowering our operational cost, to be cheaper that the competition. It doesn’t matter what type of datacenter owner you are (enterprise, cloud, co-lo, whole sale..) the competitive advantage is in the operational cost. Everyone already has a SAS70, ISO27001, ISO9001, PCI, etc.. certificate. Everyone can get and build the technology and at some point it doesn’t pay off to worry about the small engineering details anymore; the cost are too high to get enough competitive advantage in return.

Marketing & Sales

If you’re in the datacenter co-lo or whole-sales business then your marketing and sales guys are trying to look for the (next) USP.

With the datacenter efficiency on the rise, it’s nice to have a single figure to tell your customer you are more efficient that the competition (and able to offer lower prices with it..).

PUE presented a great opportunity to get a nice USP for our sales guys. And I can’t blame them: it’s hard to sell a (going) commodity product and it’s something our customers are asking for.

Sustainable & marketing

The whole ‘green wash/hype’ (before the economic crisis) added to the misuse of PUE from a sales and marketing perspective. Everyone was, and still is, building the next greenest datacenter on this planet. It would be nice to have a single figure to promote this ‘green stuff’ and tell the world about this new engineering marvel… and PUE is happily adopted for this.

On the enterprise/cloud datacenter owners side it’s not very different.. it’s just another angle. Especially the larger datacenter (cloud) owners are pushed from a marketing perspective thanks to organizations like Greenpeace. They demand full disclosure of datacenter energy use and sustainability on behalf of the world’s population.

PUE is a nice tool to get some of the pressure off and tell the world you have the greenest datacenter operation, like Facebook, Google, Microsoft and others are now doing. The problem with those numbers is they don’t say anything without the full context. And like Mark says in his article; it doesn’t say anything about the full datacenter stack.

Sustainable & Government

The really interesting thing I have been dealing with recently is government and PUE.

Many state and local government organizations are looking at datacenters from an energy use perspective. This focus is thanks to reports from research and governmental institutes (for example EPA) and organizations like Greenpeace.

Government can either use the ‘carrot (subsidies) or stick (penalties)’ approach but it always requires some kind of regulation and some form of measurement. They happily adapted PUE for this.

The main problem with this is that PUE is not ready to be audited. Sure general guidelines for PUE calculation are available, but it still doesn’t have all the full details and leaves opportunity to ‘game the system’. It also doesn’t address the full holistic datacenter approach and the fact that you cannot use PUE to compare different datacenters.

Datacenter customer

Some of the governmental organizations are also using PUE for their co-lo tenders. And they are not the only ones. More and more RFP’s on the datacenter market state a specific PUE number or target with additional credits for the lowest number.

I can’t blame the datacenter customer; the datacenter is a pretty complex facility box if you’re not educated in that industry. It would be nice to just throw some numbers at it like TIER1-4 and PUE1-2 and select the best solution provider on the market…

I can’t blame the datacenter owner for the answer with ‘the best possible number he can think of’… they just want the business…

Datacenter vendor

As usual I’m part of the problem also. When I go shopping for the next big thing in datacenter technology, PUE is always part of the conversation.

Datacenter equipment vendors (especially cooling and power) are happy to throw some numbers my way to convince me that their solution is the most efficient.

The PUE numbers are on the equipment spec sheets, on the vendor website and in the sales meeting… but at the end I always have to conclude that our little number dance really doesn’t tell me anything. Just like Mark mentions: I go back to TCO.

Our own monster

So… we created this monster as a datacenter industry. Owners and consumers. Government and industry groups. I can also assure you that this will continue and will also happen to some of the great other Green Grid initiatives like CUE, WUE and the Maturity Model. It’s just a way of trying to put a number on what can be a very complex stack of functions called ‘the datacenter’.

Only way to diminish the monster is to educate our industry colleagues and our customers. And stop throwing the numbers around…

For the record1: the use of PUE

Don’t get me wrong, I love PUE and have used it successfully many times to benchmark my own data centers and prove to senior management that we progressed in efficiency. It’s also the way the EU Datacenter Code of Conduct works: show progress every year by calculating the PUE for the same datacenter with the same calculation method. This way you will have apples – apples situation.

Its just that I don’t like the way PUE is used in the above examples…

For the record2: On datacenter and green

Full disclosure: Datacenters are not green and will never be green. They consume large amounts of energy and will consume more energy in the future. All thanks to Jevons Paradox and the fact that we start to consume more CPU/Storage if prices go down…. And yes, someone has to build datacenters for all the CPU’s and disk’s…

See GreenMonk – Simon Wardley on ‘Cloud & Green’

I do think that:

1. We should aim to build the most efficient datacenters on the planet. It should not only focus on energy consumption but on all resources used for build and operation.

2. We cannot keep up with the rising demand from an energy-grid perspective. We should start looking for alternative ways for datacenter builds and deployment.

Artikel door Jeroen Aijtink, CISSP en Jan Wiersma, Int. Director EMEA DatacenterPulse.

In de zomer van 2010 werd bekend dat er een zeer geavanceerd worm virus was gevonden die als doel had om Iraanse ultracentrifuges te saboteren. Door programma code in PLC’s van Siemens te wijzigen kon men de motoren van de centrifuges beïnvloeden. Het virus kreeg de naam Stuxnet mee en was het eerste virus dat industriële besturingssystemen als specifiek doel had.

Tot voor kort was het idee dat SCADA en industriële besturingssystemen kwetsbaar waren voor een cyber aanval, voor vele slechts theorie. Op basis van de complexiteit van deze systemen en hun bijzondere communicatie protocollen achtte leveranciers en gebruikers zich veilig tegen dergelijke aanvallen. De redenatie was dat dergelijke industriële besturingssystemen zoals PLC’s simpel weg zo verschillend zijn van normale IT systemen, dat deze geen interessant doel zijn voor traditionele hackers. De verschillen waar door de industriële besturingssystemen geen interessant doel zouden zijn waren:

Een beveiligings strategie gebaseerd op de bovenstaande systeem complexiteit en unieke systeem architecturen word door beveiliging specialisten ook wel ‘security through obscurity’ genoemd. Dit alles heeft er voor gezorgd dat de meeste SCADA netwerken slechts beveiligd zijn met een wachtwoord voor het bedienend personeel en niet veel meer.

In de afgelopen jaren is de wereld van industriële besturingssystemen en SCADA’s echter behoorlijk veranderd. (Oudere)Legacy industriële besturingssystemen bestonden uit speciale hardware, merk gebonden communicatie protocollen en aparte communicatie netwerken. Moderne industriële besturingssystemen bestaan uit standaard PC’s en servers die communiceren via standaard IT protocollen zoals IP en hun netwerk omgeving delen met andere IT eindgebruiker netwerken. Deze verandering heeft diverse voordelen opgeleverd zoals gereduceerde hardware kosten en verhoogde flexibiliteit en bruikbaarheid van deze industriële besturingssystemen. Het gaf de leveranciers van industriële besturingssystemen de mogelijkheid om hun systeem te ontwikkelen op standaard Windows of Unix platformen. De systemen kregen ook de mogelijkheid om gemakkelijke data en rapportages te delen met andere IT en netwerk systemen. Hier door zagen we in de afgelopen jaren echter wel de grens tussen IT (Kantoor Automatisering) omgevingen en de facilitaire industriële besturingssystemen vervagen. De voordelen brengen ook de nadelen van de traditionele IT omgeving met zich mee; de verhoogde kans op cyber crime.

In 2008 schreef het Amerikaanse NIST hier over in hun Guide to Industrial Control System Security: “Widely available, low-cost Internet Protocol (IP) devices are now replacing proprietary solutions, which increases the possibility of cyber security vulnerabilities and incidents.”

Dat de verhoogde kans op cyber crime een reële bedreiging vormt toonde DOE engineers van het Idaho National Engineering Lab (USA) in het Aurora Project (2007) aan. Samen met hackers van het Department of Homeland Security (DHS) startte ze een cyber aanval met als doel een grote diesel generator te vernielen. Enkele minuten nadat de hackers toegang kregen tot het SCADA systeem wist men de generator in handen te krijgen. Op een video die in 2009 getoond werd in het Amerikaanse CBS’60 Minutes was te zien dat de 27ton wegende generator gestart werd, flink begon te schudden en na enige seconde volledige gehuld was in rook. De generator overleefde de cyber aanval niet.

Het Aurora Project project toonde daar mee aan dat het mogelijk was voor hackers om via een netwerk toegang fysieke schade toe te brengen aan een generator. De hackers hadden hier bij kwetsbaarheden gebruikt die in de meeste industriële besturingssystemen vandaag de dag aanwezig zijn.

Beveiligen van een modern SCADA netwerk

Het feit dat leveranciers van moderne SCADA systemen deze gebaseerd hebben op standaard IT onderdelen en protocollen, levert wel als voordeel op dat er al veel kennis is over beveiliging van dergelijke omgevingen.

De basis voor een goed beveiligde omgeving begint met het bepalen van dreigingen en risico’s die er zijn voor de organisatie en zijn infrastructuur. Door het combineren van de facilitaire systemen met de IT-omgeving is de stelling “we hebben toch een firewall” niet meer afdoende. Denk bijvoorbeeld aan het draadloze netwerk, laptops van bezoekers of een account manager die regelmatig via draadloze netwerken in hotels of restaurants op Internet gaat. Let ook op zaken die niet direct met ICT te maken hebben. Welke (openbare) informatie is over de organisatie beschikbaar, welke communicatie stromen zijn er met onderhoudsleveranciers en hoe controleer ik de onderhoudsmonteur. De vraag ‘waartegen beveilig ik de organisatie’ is een belangrijke vraag om te beantwoorden. Iedere organisatie heeft tenslotte andere tegenstanders.

Goed beveiligingmaatregelen zijn afgestemd op de bedreigingen en tegenstanders van een organisatie. Zorg dat beveiligingmaatregelen bruikbaar zijn en de processen de organisatie ondersteunen. Naast techniek is scholing van medewerkers over beveiliging erg belangrijk.

Om een bedrijfsnetwerk te beveiligingen is het creëren van verschillende zones het uitgangspunt. Iedere zone heeft zijn eigen functie en de overgang tussen zones verloopt via een firewall. Communicatie met een zone die minder vertrouwd worden, zoals Internet, verloopt via een proxy-server in een demilitarized zone. Door de proxy-server ontstaat een scheiding in de verkeersstroom en wordt de inhoud gecontroleerd op virussen en malware. Houdt ook het rekencentrum voor kantoorautomatisering en de facilitaire systemen gescheiden van elkaar met eigen zones.

Door de verschillende zones zijn de facilitaire systemen gescheiden va

n de IT-omgeving en communicatiestromen hiernaar toe zijn te inspecteren met intrussion detection systemen. Een tweede voordeel van het aanbrengen van zones is een performance verbetering doordat communicatiestromen elkaar niet hinderen.

Naast beveiliging binnen het netwerk zijn servers, besturingssystemen, applicaties en databases goed beveiligd en voorzien van de laatste (security) patches en antivirus software. Server beveiliging is belangrijk, omdat de firewall alleen kijkt of de communicatie toegestaan is terwijl antivirus software de servers beveiligd tegen bekende virussen. Patches voor het besturingssysteem zorgen dat beveiligingslekken gedicht worden. Na installatie moet software in een doorlopend proces onderhouden worden.

Steeds meer facilitaire systemen hebben remote-support vanuit de leverancier. Denk hierbij goed na over welke informatie de organisatie kan verlaten. Daarnaast kan het een goed idee zijn om de leverancier alleen toegang te geven wanneer er daadwerkelijk een probleem is. Het oplossen van storingen vanuit de locatie lijkt ouderwets, maar geeft wel de meeste controle. Zeker wanneer de monteur begeleid wordt door iemand die inhoudelijk kan beoordelen wat deze uitvoert.

Bovenstaande lijkt niet in lijn te zijn met de visie, van de laatste jaren, op informatiebeveiliging volgens Jericho. Jericho gaat uit van netwerken zonder “firewall-slotgrachten”, waarbij beveiliging aangebracht wordt daar waar dat nodig is op de servers en werkplekken. De traditionele firewall zou hierdoor overbodig zijn. Wanneer beveiliging op alle systemen integraal geregeld is kan de firewall uit. Voordat dit moment is aangebroken is er bij veel organisaties nog een lange weg te gaan.

Enige tijd geleden, tijdens een verhitte Twitter conversatie tussen cloud guru’s en evangelisten, stelde ik mijn lijst met cloud regels op. Aangezien Twitter nogal ongenuanceerd is met een beperkt aantal karakters volgt hier een samenvatting met wat tekst en uitleg:

Regel 7

Er is veel discussie over cloud definities. Wat is nu wel en wat is nu niet cloud ? De meest gebruikte definitie is die van NIST (pdf).

Echter kijkend naar de ontwikkelingen in de markt en de volwassenheid van de oplossingen , ga ik echter een stapje verder: een generieke definitie van cloud is op dit moment niet relevant.

De scope van o.a. de NIST definitie is op dit moment al erg breed. Met alle ontwikkelingen die er nog komen, zullen we de definitie steeds moeten aanpassen. Over een paar jaar zullen veel van deze ontwikkelingen zo gewoon zijn voor ons dagelijks IT gebruik, dat we het niet meer cloud zullen noemen. Daar waar een ‘definitie’ voor cloud wel van toepassing is, is binnen je eigen organisatie. Dat bevorderd de communicatie tussen bijvoorbeeld IT en de business.

De inhoud van die definitie is opzicht niet eens zo heel relevant, als je maar iets gezamenlijks afspreekt.

Tussen jou en alle leveranciers… tja, daar ga je gedurende de hele cloud hype fase nooit uitkomen. Zodra we in Gartners "Trough of Disillusionment" komen zullen alle marketing afdelingen snel afscheid willen nemen van de cloud term.

Om met de woorden van Simon Wardley te eindigen: Cloud; It’s like computers on the internet, innit?!?

Regel 6

Voordat je cloud computing gaat inzetten als middel, dien je een exit strategie te formuleren. Bij de meeste cloud oplossingen maak je jezelf enigszins afhankelijk van een leverancier of een technologie. Dit is soms omdat er data opslag plaats vind bij de leverancier of wegens het afstemmen van je architectuur of ontwerpen op die van de leverancier.

Je dient dus een plan te hebben om afscheid te kunnen nemen van de cloud leverancier. “Hoe krijg ik mijn data terug?” bijvoorbeeld.

Regel 5

Diverse nieuwe applicatie frameworks geven de mogelijkheid om applicaties te ontwikkelen die minder gevoelig zijn voor de variabele performance van het basis netwerk dat ‘het internet’ heet. Dit is nodig omdat de gebruiker van de applicatie soms de functionaliteit via een mobiele internet verbinding gebruikt en dan weer via een ADSL2 verbinding. Daarnaast levert de manier waar op het internet technisch is uitgelegd altijd variabele performance. De nieuwe technologische mogelijkheden zorgen er voor dat men zich minder druk hoeft te maken over latency. (denk aan video streaming zoals Netflix doet)

Zie ook: http://jwiersma.wordpress.com/2011/01/08/paas-de-toekomst-van-programmeren-1/

Regel 4

Bij het bouwen van cloud applicaties dient men rekening te houden met uitval van software, delen van hardware, complete servers en zelfs complete datacentra. Dit betekend bijvoorbeeld op een juiste manier om gaan met state en stateless.

De nieuwe applicatie framewerken en vooral de PAAS oplossingen die geboden worden, hebben hier voor diverse standaard mogelijkheden.

Zie: http://jwiersma.wordpress.com/2011/01/08/paas-de-toekomst-van-programmeren-1/

Regel 3

Veel IT-ers stappen de cloud wereld in met het idee dat ze hun gedachtegoed, ontwerpen en applicaties zo mee kunnen mee nemen en ‘in de cloud kunnen gooien’. Zo werkt dat echt niet.

Om goed in een cloud omgeving van een leverancier te kunnen werken moet je hun architectuur en ontwerpen goed begrijpen en kunnen toepassen.

Zie:

http://jwiersma.wordpress.com/2011/02/21/mijn-cloud-is-beter-dan-die-van-jou/

http://jwiersma.wordpress.com/2011/04/22/mestvorkknuppels-uit-de-stal-de-cloud-is-down/

Regel 2

Cloud geeft de mogelijkheid om functionaliteit die uitermate gestandaardiseerd is (commodity IT) buiten de organisatie te plaatsen en je te concentreren op zaken die je een voordeel geven op de concurrentie.

Zo levert het hebben van een tekstverwerker of een spreadsheet programma al lang geen voordeel meer op; de concurrentie kan deze ook gewoon kopen en implementeren. De vraag is dus hoeveel geld je moet uitgeven om deze functionaliteit in eigen huis te ontwikkelen en beheren.

Zie:

http://jwiersma.wordpress.com/2010/11/06/en-dan-die-applicatie-naar-de-cloud-toe/

http://jwiersma.wordpress.com/2011/01/31/de-nieuwe-overheid-i-strategie-cloud/ (laatste paragraaf)

Regel 1

Cloud is vooral voor en door de eindgebruiker. Daarbij moet de IT-er vooral de organisatie helpen in te transitie. Een afwerende houding op dat vlak zal cloud computing niet buiten te deur houden en zal de eindgebruiker naar Schaduw-IT drijven.

Deze regel is beschreven in ‘de opkomst van Schaduw-IT’: http://jwiersma.wordpress.com/2011/07/06/de-opkomst-van-schaduw-it/

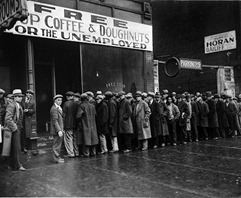

Op 1 augustus j.l. kopte de New York Times:

Data Centers’ Power Use Less Than Was Expected

Data centers’ unquenchable thirst for electricity has been slaked by the global recession and by a combination of new power-saving technologies, according to an independent report on data center power use from 2005 to 2010.

Het artikel is gebaseerd op een onderzoek van Jonathan G. Koomey die voor Stanford University werkt en een bekende is in de datacenter wereld met eerdere onderzoeken.

Het onderzoek komt tot de conclusie dat de energie afname voor datacentra niet zo hard gegroeid is als eerder voorspeld werd in de rapporten van de EPA.

De reden voor de verminderde groei zou te vinden zijn in:

Minder servers?

De eerste twee redenen zouden uit de server verkoop cijfers te halen moeten zijn en dat doet Koomey aan de hand van IDC cijfers van 2007 v.s. 2010. (pagina 20 rapport). Als we deze cijfers langs die van een andere markt analist liggen, Gartner, komen deze redelijk overeen. In september 2009 gaf Gartner aan dat de server verkoop zo’n 28% lager was dan die periode een jaar geleden (2008);

In the second quarter of 2009, worldwide server shipments dropped 28 per cent year-on-year, while revenue fell 29.4 percentage points year-on-year, according to Gartner, Inc.

“The server market remains constrained on a worldwide level,” said Jeffrey Hewitt, research vice president at Gartner. “Server sales have felt the impact of reduced budgets since the last half of 2008 and the second quarter of this year remained in the negative.”

In mei 2010 rapporteerde ze dat er een groei geboekt was van 23% ten opzichte van het voorgaande jaar (2009);

Worldwide server shipments grew 23 percent year over year in the first quarter of 2010, while revenue increased 6 percent, according to Gartner, Inc.

"We’ve seen a return to growth on a worldwide level, but the market has not yet returned to the historical quarterly highs that were posted in 2008,

Maar de groei was nog niet op het niveau van 2008. In november 2010 werd nog steeds groei gemeten van zo’n 14%. IDC gaf recent aan dat de verkoop in de lift zit en behoorlijk zal stijgen. Dit zou te danken zijn uit de wereldwijde uitrol van cloud computing initiatieven;

Investments in private and public clouds will spur worldwide server sales over the next four years to the tune of $9.4bn (£5.8bn), according to IDC.

<IDC> estimates 1.2 million systems that underpin public cloud deployments will be shipped by 2015, a compound annual growth rate of 21 per cent and 570,000 servers to be sold for private cloud implementations, CAGR of over 22 per cent.

Bij al deze server markt groei cijfers moet echter wel opgemerkt worden dat ze wel relatief zijn en zeggen niets over het feit of het energie efficiënte modellen zijn en of deze in hoog efficiënte datacentra terecht komen. Daarnaast is de focus van de eerder genoemde energie groei in datacentra onderzoeken, die van de US situatie en moeten de server verkoop cijfers dus per geografische markt bekeken worden.

Het lijkt echter valide om te stellen dat de dalende server verkoop heeft bijgedragen aan de verminderde groei van energie afname van datacentra.

Energie afname per server.

Als we kijken naar energie afname in een datacenter dan zien we dat er een hele energie keten is waar verbruik en verlies in optreed. Deze is duidelijk te zien in de DatacenterPulse Stack of het Cascade Effect van Emerson:

Deze laatste geeft een aardig beeld waarbij elke watt die bespaard word bij de bron totaal 2,84 watt aan besparing levert. Dit is uiteraard afhankelijk van alle schakels die er tussen zitten en de efficiëntie daar van. Als we kijken naar de totale energie last van een datacenter is het dus zeker interessant om te kijken naar de ontwikkeling van server componenten in de afgelopen jaren.

Dus de HP power calculator gepakt en een theoretische berekening gemaakt:

| Productie Jaar | Type | CPU’s | RAM | HD | Afname |

| 2003 | DL360 | 2 (PII) | 4 | 2x 18GB | 176W |

| 2004 | DL360G3 | 2 | 8 | 2x 36GB | 360W |

| 2008 | DL360G5 | 2 (Intel L5240) | 8 (low power) | 2x 36GB | 238W |

| 2011 | DL360G7 | 2 (Intel L5630) | 8 (low voltage) | 2x 60GB SSD | 160W |

Los van het feit dat dit een theoretische benadering is en n

ogal hoog over, levert het een aardig aanknopingspunt: in de server ontwikkeling hebben we een grote sprong gezien in energie toename met de komst van snellere systemen. Echter zijn er in de afgelopen 2 a 3 jaar grote stappen gemaakt in het terug dringen van dat energie verbruik. In bovenstaande berekening zien we dat een snelle quadcore machine met solid-state disken minder energie verbruikt dan zijn broertje met een Pentium 3 CPU uit 2003.

Een collega zetten mij recent op dit spoor toen we keken naar het aantal ampère dat er per rack verbruikt word en de groei hier van; bij rackmount servers bleek dit redelijk te stabiliseren en op bepaalde vlakken zelfs te dalen.

We kunnen dus wel stellen dat de servers die vandaag de dag gekocht worden zuiniger zijn dan voorheen en zeker bijdragen aan de daling die gesignaleerd word in het rapport van Koomey. Zeker als we het cascade effect er nog eens overheen gooien. De combinatie van efficiëntere servers, die beter uitgenut worden door virtualisatie zal het verhaal alleen nog maar versterken.

De grote glazen bol

De vraag is nu echter waar gaat het de komende jaren heen en zet de daling zich voort of is het slechts uitstel van executie? Het antwoord hier op ligt op een aantal vlakken:

1. Besparingen.

De ontwikkeling van energie zuinige servers zet zich voort. Neem als voorbeeld de inzet van de ARM en Atom CPU voor servers. Mensen die recent een keynote van mij hebben gevolgd weten dat ik daar een fan van ben en deze ontwikkeling op de voet volg. Voorbeeld: Low-power server startup pitches Intel Atom for Hadoop en zoals Gigaom enige tijd geleden melde:

ARM-based servers will consume a fraction of the power and space demanded by today’s most efficient servers. Performance per “core” will be lower, but clusters of these efficient nodes will consume perhaps as little as 1/10th as much power to deliver comparable performance. Couple that with huge gains in performance density to realize massive savings potential in data center capital expenditures.

De ontwikkelingen op het efficiëntie gebied van datacentra gaat ook door. De grote datacentra ontwikkelen zich langzaam naar de PUE onder de 1.1. Daar zien we de ontwikkeling in technologie en de discussie over temperatuur in het datacenter die ik al eerder in een blog behandelde. Er blijft echter een groot markt aandeel van kleiner datacentra die zich nog nooit druk heeft gemaakt over PUE. Deze zitten o.a. in kantoorpanden met hun datacentra. Google is nu gestart met een stuk bewustwording voor dit deel van de markt met de publicatie van hun Best practices.

2. Groei.

Zoals ik beschreef in de Jevons Paradox blog zullen we de komende jaren behoorlijke groei zien in de cloud computing markt. Dit levert verhoogde afname van servers zoals IDC dus al schetste. Ook zal dit leiden tot meer en grotere datacentra. (Deze servers en datacentra zijn dan hopelijk wel zo efficiënt mogelijk..) Dit werd ook geschetst door Christian Belady (Microsoft) bij zijn toekomst schets van datacenter bouw markt.

Met de mate van groei in afname van cloud computing producten die nu al te zien is in de markt denk ik echter dat we Gartner (2007!) gaan volgen:

Ze hadden dan wel niet de economische crisis zien aankomen toen ze deze in 2007 opstelde, maar die scherpe daling mede dankzij nieuwe (efficiënte) technologieën is heden ten dagen wel te zien. De energie consumptie zal daarna weer toe nemen wegens de massale groei aan servers en datacentra vanuit Jevons paradox. Zoals Simon Wardley daarbij aangeeft:

By increasing efficiency and reducing cost for provision of infrastructure, a large number of activities which might have once not been economically feasible become economically feasible.

…

The effect of these forces is that whilst infrastructure provision may become more efficient, the overall demand for infrastructure will outstrip these gains precisely because infrastructure has become a more efficient and standardised component.

De ontwikkeling in energie efficiënte servers en datacentra zal de groei iets temperen maar de vraag is daarbij enkel: hoe hard gaat de totale groei en volgens welk (EPA) scenario ?

Meer: Blog J. Koomey

Zoals gisteren aangekondigd op Twitter en de DatacenterPulse website, is DatacenterPulse samen met eBay het 2e open RFP project gestart. Dit maal voor een datacenter ontwerp in Salt Lake City, Utah. Het project heeft de naam QuickSilver mee gekregen.

Bij het vorige open-RFP project Mercury werd de datacenter ontwerp markt uitgedaagd om een maximaal flexibel datacenter te ontwerpen voor eBay in Phoenix. Hierbij was ook de eis dat men het gehele jaar 100% free cooling toegepast kon worden. Daarnaast was de eis:

De winnende ontwerpen werden op 22 februari 2011 gepresenteerd aan de DatacenterPulse leden tijdens de Modularity Readout op de Google campus. Het project bereikte zijn doel: de markt uitdagen om met innovatieve ontwerpen te komen voor datacentra en deze kennis delen met andere datacenter eigenaren.

Project QuickSilver neemt de leerpunten uit het vorige open-RFP project mee voor de volgende uitdaging;

We are consutructing a new building on one of the three adjacent 15 acre phases of the Salt Lake City, Utah Data Center that we opened in 2010. You can see the phases from the arial photo below. The initial delivery of IT critial power will be 4MW, with scale to 30MW. The design must be completed in Q1 of 2012, with construction starting in Q2 and full commissioning complete by 12/21/2012.

Hierbij zijn de volgende eisen gesteld:

De beste 5 ontwerpen worden ook weer gedeeld met datacenter eigenaren uit de 1500+ leden groep van DatacenterPulse.

De project pagina is hier: http://datacenterpulse.org/rfp/modular/quicksilver. De inschrijving is 19-8 geopend.

Als het om cloud computing gaat zijn vaak (enterprise) IT-ers er als de kippen bij om me te vertellen dat het allemaal toch niet gaat werken, onveilig en onstabiel is. Ik heb vaak grotere discussies met mijn IT vakbroeders dan met de business zijde van de organisatie.

Als het om cloud computing gaat zijn vaak (enterprise) IT-ers er als de kippen bij om me te vertellen dat het allemaal toch niet gaat werken, onveilig en onstabiel is. Ik heb vaak grotere discussies met mijn IT vakbroeders dan met de business zijde van de organisatie.

In een recente discussie over de implementatie van cloud computing bromde een IT-er: “dat cloud gedoe… dat kost me nog eens mijn baan…”.

Als je sommige berichten (en marketing) rond cloud mag geloven, heeft hij gelijk. ‘Zet al je IT maar buiten de deur en in de cloud… en je leven word een stuk beter’, lijken deze verhalen te zeggen. Daarbij ‘gaan de kosten flink omlaag, want je hebt geen IT-er meer nodig’.

Als je jaren hebt gewerkt aan de implementatie van een stuk infrastructuur en de optimalisatie daar van, en er komt nu een leverancier langs die met het bovenstaande je levenswerk afdoet als een hobby project… ja, dan zou ik ook boos worden.

Zoals altijd ligt de echte waarheid ergens in het midden. Een kleine voorspelling hoe het de komende jaren gaat uitspelen:

Dit alles betekend nogal wat voor de ICT-er van nu. Al eerder gaf ik een beschrijving van de impact die PAAS op mijn collega software ontwikkelaars kan hebben. IAAS heeft een mogelijk nog grotere impact op de IT infrastructuur ontwikkelaars en beheerders.

Dit alles betekend nogal wat voor de ICT-er van nu. Al eerder gaf ik een beschrijving van de impact die PAAS op mijn collega software ontwikkelaars kan hebben. IAAS heeft een mogelijk nog grotere impact op de IT infrastructuur ontwikkelaars en beheerders.

Sommige mensen zien alle veranderingen als een kans en andere als een bedreiging. Feit is echter dat ICT altijd een snel veranderd vakgebied is geweest en zal blijven;

In het begin van mijn ICT carrière begon ik met Windows NT 3.51 aan de workstation kant en Novell NetWare 3.12. Binnen enkele jaren en vele uren aan zelf/avond studie had ik mezelf voorzien van certificaten van Certified Novell Administrator (CNA) tot tig examens verder MCNE. Ik kende werkelijk bijna elk commando uit mijn hoofd met volledige opties en wist blind te navigeren binnen bepaalde menu’s.

Allemaal kennis waar ik 10 jaar later niets meer aan heb… Verandering is de enige constante in het ICT vakgebied.

Nieuwe kansen.

Zolang je bereid bent te veranderen en bijscholen en te gaan voor nieuwe uitdagingen, zijn er een hoop kansen:

In de komende jaren zullen bepaalde banen verdwijnen en zullen er nieuwe ontstaan. Aan de cloud aanbieders kant zal een vraag ontstaan naar mensen die grootschalige, multitendant, infrastructuren kunnen ontwerpen, bouwen en onderhouden. Hierbij zal expertise worden gezocht in parallel processing, virtualisatie, energie management en koeling, security en encryptie, high-speed netwerken en data caching (CDN) en gerelateerde vakgebieden. Daarnaast zal veel software moeten worden herschreven om (efficiënt) te kunnen werken op een cloud platform.

Aan de eindgebruikers kant zal, nu we de transitie maken naar een utility en services model, de vraag naar IT-ers voor het bouwen en onderhouden van in-huis systemen zien afnemen. De vraag naar kennis en skills rond informatie management, proces ontwerp en automation zullen echter toenemen. Er zullen ook nieuwe IT rollen ontstaan. Een ‘(cloud) services broker’ zou een rol kunnen zijn waarbij deze persoon de brug vormt tussen (externe) cloud services en de interne business units. Dit zullen steeds meer regie functies worden. Binnen bedrijven die op dit moment een agressief cloud adoptie beleid toepassen, is die wijziging binnen hun IT afdelingen al te zien; de grote van de IT afdeling neemt af, maar de meer senioren en strategische rollen nemen toe.

Aan beide zijde (cloud aanbieder en afnemer) zal de vraag toenemen voor IT-ers die over de traditionele silo’s heen kunnen denken en ontwerpen. Dit is terug te zien aan de opkomst van DevOps aan de cloud provider kant en de vraag naar cloud/services architecten aan de afnemer kant. Deze vaardigheid, om relaties tussen diverse IT disciplines te kunnen onderscheiden en bouwen, is iets wat ontstaat uit het werken en ervaring op doen in verschillende rollen gedurende je carrière. Met de naderende krapte op de markt, zal er flink gevochten worden om dit senioren ontwerpers/architecten. Zoals Gartner analist Dave Cappuccio opmerkte:

…sit back and think about the most valuable people in the IT organization — those people who always get the projects handed to them, because we know they’ll get things done, regardless. If you look at the strengths they bring to any project, it’s rarely depth of knowledge (the vertical T), but breadth of understanding (all the linkages). Drill-down specialists are available in all disciplines, but the linkag

e masters are hard to find.

(Het gehanteerde T-profiel word ook beschreven in het uitstekende boek: “Leidinggeven aan professionals? Niet doen!” van Mathieu Weggeman.)

Dit alles schetst dus juist een rooskleurig beeld voor de IT-er. Veel kansen om met nieuwe technologie aan de slag te kunnen in omgevingen die groter zijn en worden dan ooit. Het betekend echter wel dat er flink gewerkt moet worden aan het verweven van de juiste skill-sets.

Neem afscheid van het Iejoor complex

Zoals Mike Manos recent aan gaf, hebben veel datacenter managers (en IT-ers) last van het Iejoor complex en gedragen zich als die ‘sombere knuffelezel’ (3:43), als het gaat om cloud computing:

Dus tijd voor actie en tijd om de kansen te pakken:

Meer Cloud en werk:

Zoals ik eerder in presentaties en andere blogs schetste is de technologische wereld om ons heen de afgelopen jaren aardig snel veranderd. De techniek heeft in vele huizen een PC en internet gebracht en tenminste 1 tot enkele mobieltjes, waar van steeds meer met mobiel internet. Deze geleverde techniek is ook gemakkelijker geworden en gebruiksvriendelijker. De iPad is daar een voorbeeld van; eenvoud, gebruiksgemak, mobiel en overal verbinding.

Dit soort ontwikkelingen nemen ook vaak veel zorgen uithanden, die vroeger voor nogal wat uitdagingen zorgde. Met een aantal klikken word er gezorgd voor opslag van je data die altijd en overal (via internet) bereikbaar en toegankelijk is.

De persoonlijke ontwikkeling van mensen op technisch vlak heeft ook sprongen vooruit gemaakt. Het gemak waar mee de jongere generatie om gaat met nieuwe technologie staat in schril contrast tot de angst die veel oudere generaties kende voor technologische producten zoals de PC.

Deze twee trends zetten zich ook voort binnen bedrijven en hun IT voorziening. De afgelopen decennia lag de macht over het IT platform bij de IT afdeling. Deze bepaalde wat er goed was voor de organisatie en wat er wel en niet kon. De controle die de IT afdeling daarbij wilde hebben over de IT middelen stond regelmatig op gespannen voet met gebruiksvriendelijkheid en bruikbaarheid van deze middelen. De meeste eind gebruikers legde zich daarbij neer. Echter niet allemaal; zo heb ik in het begin van mijn IT carrière een jaar lang ‘kat en muis spelletjes’ gespeeld met scholieren om de school PC’s dicht gespijkerd te houden. Dit was een oneindig gevecht en eindigde in een echt onwerkbare situatie. (Daar op besloot ik het PC platform open te laten en aan de eindgebruiker terug te geven… wat uiteindelijk de beste zet bleek…)

Deze twee trends zetten zich ook voort binnen bedrijven en hun IT voorziening. De afgelopen decennia lag de macht over het IT platform bij de IT afdeling. Deze bepaalde wat er goed was voor de organisatie en wat er wel en niet kon. De controle die de IT afdeling daarbij wilde hebben over de IT middelen stond regelmatig op gespannen voet met gebruiksvriendelijkheid en bruikbaarheid van deze middelen. De meeste eind gebruikers legde zich daarbij neer. Echter niet allemaal; zo heb ik in het begin van mijn IT carrière een jaar lang ‘kat en muis spelletjes’ gespeeld met scholieren om de school PC’s dicht gespijkerd te houden. Dit was een oneindig gevecht en eindigde in een echt onwerkbare situatie. (Daar op besloot ik het PC platform open te laten en aan de eindgebruiker terug te geven… wat uiteindelijk de beste zet bleek…)

Waar vroeger kantoor personeel misschien wel eens dacht “ik neem mijn laptop van thuis mee…”, had je daar niets aan omdat je deze meestal niet aan het bedrijfsnetwerk kon aansluiten. Mobiel internet heeft dat veranderd. Nu je op kantoor met je eigen mobiele internet verbinding aan de slag kunt, op je eigen smartphone/ipad/laptop, staat je weinig meer in de weg. Zo was het interne mail systeem al niet meer toereikend wegens de opgelegde mail quota van 250mb, dus je stuurde alles al door naar je Gmail account. Ook het delen van documenten bleek makkelijker via Dropbox of Google Apps. Contact zoeken met collega’s ? Dat doen we even via Yammer… en het CRM systeem hadden we ook niet meer nodig want Salesforce was beter en sneller bruikbaar. Deze trend word ook wel ‘schaduw-IT’ genoemd.

Cloud computing heeft een extra impuls gegeven aan het bovenstaande scenario. Met behulp van een creditcard kunnen niet alleen SAAS services (zoals beschreven in het stukje hier boven) maar ook IAAS en PAAS services. Bij PAAS services zien we ook de opkomst van eenvoudige programmeer platformen. Het zelf in elkaar zetten van Apps word daar mee ook gemakkelijk gemaakt voor de eind gebruiker.

Cloud computing is daar mee onderdeel van een eindgebruikers revolutie. Logisch dat het door veel IT-ers met achterdocht bekeken word.

De mensen van Centre4Cloud zetten deze revolutie vanuit het oogpunt van de CIO aardig neer; de governance op zijn kop en de macht bij de eindgebruiker:

Uiteraard kan de IT afdeling het gebruik van cloud services verbieden en proberen op die manier maximale controle te houden. Het is echter een utopie om te denken dat dat ook zal lukken. De hoeveelheid cloud services zijn nu al legio en de mogelijkheden zijn bijna onbeperkt. Sinds de eindgebruiker ook de mogelijkheid heeft om zelf een netwerk verbinding mee te nemen (mobiel internet), zijn verbodsmaatregelen bijna on begonnen werk.

De IT-afdeling kan zich daarom beter richten op het faciliteren van de cloud mogelijkheden. Dit door samen met de gebruikers te kijken naar de selectie van de juiste cloud services en de beste manier om deze te integreren met de eigen in-huis ICT.

Dit alles sluit ook aan bij een andere manier van beveiligen van het bedrijfsnetwerk zoals bijvoorbeeld met Jericho concepten. Een aardige parallel hier in is te vinden in het gevecht dat BlackBerry voert op het vlak van enterprise IT, zoals recent in een artikel van Security Week stond:

Employees love choice, flexibility, and fashion. That is why they are buying iPads by the pallet-load. The rise of consumer-grade Post-PC devices means that IT security must say goodbye to standard hardware platforms, sanctioned corporate anti-malware software, and consistently enforced security policies. That is why they are concerned, and why worried IT managers are RIM’s natural target audience.

Seen against the backdrop of consumerization, the PlayBook’s relative success or failure in the enterprise market is nothing less than a referendum on IT’s ability to impose its will as we enter the Post-PC era. The PlayBook device is essentially IT’s last stand. Will safe, IT-sanctioned devices win, or take a back seat to employee and consumer tastes?

Ondertussen in IT-land…

Binnen de IT afdelingen loopt op dit moment de druk op; de budgetten staan onder druk, prestatie is onder de maat en business eigenaren vragen zich af waarom de opslag bij Amazon zoveel goedkoper is dan de eigen opslag…

De IT-ers doen waar ze goed in zijn: consolideren, invoeren van nieuwe technieken als virtualisatie, door voeren van shared service centra… Op zich allemaal niets nieuws onder de zon voor de IT.

Dit zien we bijvoorbeeld bij onze Nederlandse overheid ook terug; datacenter consolidatie en meer samen werken. We weten ook al lang dat dit niet slaagt zonder goede afspraken en procedures. Dus de governance moet ingeregeld worden, ITIL boeken uit de kast, beveiligingsconcepten op elkaar afstemmen… Zaken die we ook al meer dan eens hebben gedaan in de IT.

Het aardige is echter, dat de wereld om de IT-er wel behoorlijk veranderd is. Terwijl de IT afdeling lekker met zich zelf bezig is, neemt de ‘schaduw-IT’ explosief toe. Deze wacht namelijk niet tot alle processen netjes op orde zijn en systemen geconsolideerd. De eindgebruiker wil en moet namelijk verder… en zoekt daar in zijn eigen weg.

Daar ligt dus de echte uitdaging voor de huidige CIO; de juiste balans vinden tussen het ondersteunen van de eind gebruiker met cloud services en ondertussen zijn eigen winkel verbouwen.

En bij dat laatste… komt wel wat ‘creative destruction‘ kijken. :-)

Zoals aangekondigd in enkele persberichten zal ik de Nederlandse overheid per 1 mei verlaten.

Met gemengde gevoelens heb ik ongeveer 1 maand geleden mijn ontslag ingediend. Zo’n zes jaar geleden startte ik bij de nu oud-werkgever. De overheids ICT was niet vreemd voor mij aangezien ik een aantal jaren daarvoor bij ITO (agentschap BZK) had gewerkt. De tussenstap was een paar jaar IT consultancy, waarbij ik op het einde wat meer behoefte kreeg aan een betere werk-privé balans. De terugkeer was als een warm bad; ik trof veel van mijn oude collega’s verspreid over de gehele organisatie waarmee de samenwerking al snel weer als vanouds was.

Met gemengde gevoelens heb ik ongeveer 1 maand geleden mijn ontslag ingediend. Zo’n zes jaar geleden startte ik bij de nu oud-werkgever. De overheids ICT was niet vreemd voor mij aangezien ik een aantal jaren daarvoor bij ITO (agentschap BZK) had gewerkt. De tussenstap was een paar jaar IT consultancy, waarbij ik op het einde wat meer behoefte kreeg aan een betere werk-privé balans. De terugkeer was als een warm bad; ik trof veel van mijn oude collega’s verspreid over de gehele organisatie waarmee de samenwerking al snel weer als vanouds was.

Na een half jaar kreeg ik de mogelijkheid om een nieuw team en omgeving op te gaan zetten voor de OTA van infrastructuur ontwikkelingen. Dit al snel gevolgd door een OTA omgeving voor software ontwikkelingen. Dit waren zeer leerzame jaren voor mij. Ik had wel sturende ervaring vanuit een project management rol, maar nog nooit als leidinggevende. Ondersteund door een goed intern management development traject en coaching kon ik mij eerste stapjes op dit vlak zetten. Daarnaast had ik het geluk om deel uit te mogen maken van een MT waar in mensen zaten met grote leidinggevende en bestuurlijke ervaring en kennis. Ze waren altijd bereid mij te helpen met raad, daad en feedback.

Met de financiële deel-verantwoordelijkheid van de OTA omgevingen werd ik ook geconfronteerd met het financiële controle vak. Met zaken als OPEX, CAPEX, inkomsten, uitgaven en budgeten duizelde het me al snel. Gelukkig werd ik ondersteund door een aantal kundige financieel controllers die mij de kneepjes van hun vak geprobeerd hebben bij te brengen.

Ook technisch inhoudelijk was het een interessante periode; technieken als blade servers en virtualisatie deden hun intrede. Het gebied van fysieke datacenter management was ook nog aardig braakliggend terrein. Omdat ik me mocht bezighouden met test en ontwikkeling, kwamen alle nieuwe innovaties als eerste daar langs. Soms zelfs in een beta vorm rechtstreeks uit de fabriek van de leverancier. We hadden de kans om hiermee zeer innovatieve Proof Of Concepts (POCs) uit te voeren. Dit gaf je constant een blik op de toekomstige ontwikkelingen van ICT en de richting die het aan het nemen was. Hierbij was het ook interessant welk effect technologische ontwikkeling hebben op de noodzakelijke organisatie en proces inrichting en het financieel model.

Naast mijn formele rol voor de OTA omgevingen, kreeg ik de kans wat andere klussen er bij te mogen doen die op het tactische en strategische vlak voor de gehele organisatie lagen. Dit gaf de mogelijkheid om bijvoorbeeld uitgebreid in de exploitatie onderdelen te kijken vanuit een project voor de implementatie en standaardisatie van beheer tools. Daarbij kon ik altijd terug vallen op mijn eigen teams of andere mensen om mij heen, die een schat aan ervaring hadden. Tot op de dag van vandaag werd ik hierbij steeds weer positief verrast door de kennis, kunde en inzichten van bepaalde mensen in de organisatie. Een collega verwoorde dat een goed jaar geleden aardig onder de noemer “schateilanden”. Ze zijn er, maar je moet wel een kaart hebben en een stukje varen om ze te vinden…

Naar mate ik me meer met de strategische richting van de organisatie mocht bezighouden gingen we wel een aantal dingen opvallen. Dit waren vooral zaken waar mee een rationeel ingestelde techneut als ik af en toe een worsteling had;

Daar waar de financiële crisis uiteindelijk voor veel organisaties en bedrijven een kans was om ICT beter te gaan inzetten en uitnutten, zag ik bij veel overheidsorganisaties dat het politieke resultaat de boventoon ging voeren.

Niet uniek…

Veel van de zaken die daarnaast de ICT van de overheid troffen, zijn zaken waar mee veel organisaties en bedrijven worstelen:

De overheid is daar niet uniek in, maar kent in de oplossings sfeer geen commerciële/financiële prikkel maar enkel een politieke prikkel. En daar ligt de uitdaging; wat ga jij als ICT organisatie er aan doen om bovenstaande problemen op te lossen. Word je daarbij gedreven door het politieke resultaat, resultaat voor de eindgebruiker, of het resultaat voor je eigen ICT koninkrijk?

In 2008 kreeg ik de kans om me bezig te houden met de toekomstige datacenter strategie. Samen met een aantal zeer gewaardeerde en slimme collega’s heb ik hier met veel plezier aan gewerkt. In korte tijd deed ik een aantal inzichten op over de richting waar enterprise ICT zich in aan het ontwikkelen was. Dit gecombineerd met de kennis en ervaring vanuit de OTA omgevingen, gaf ook een beeld hoe organisatie en proces inrichting van een ICT organisatie zou moeten veranderen.

Met enkele collega’s zat ik hiermee in het innovator kwadrant en raceten we voor de organisatie uit; wij stonden al aan de andere kant van de berg terwijl de rest nog aan een moeizame beklimming moest beginnen. Als ik mezelf iets verwijt in de afgelopen 2 jaar is dat het feit dat ik de collega’s hierbij iets meer had moeten meenemen op dit pad. Soms was mijn hoofd zo ver vooruit dat het moeilijk was voor mensen om nog aan te haken. Zoals een collega zei: “jij zit met je hoofd in de ‘clouds’ en wij staan nog met onze voeten in de modder”. 🙂

De komende jaren worden spannend en intensief voor overheids ICT. Snelle ontwikkelingen op technologisch vlak, mondige en veranderde eindgebruikers populatie, aanstaande krapte op de arbeidsmarkt, reorganisaties en de bezuinig doelen zorgen voor een hoop turbulentie.

Intern heb ik geprobeerd richting te geven aan de manier waar op ICT technologie dit zou moeten ondersteunen. Op het rijksoverheid vlak heb ik daar ook al eerder over geschreven. Wij techneuten en technisch adviseurs kunnen hier in een hele hoop

oplossingen en scenario’s bedenken die allemaal naar de stip aan de horizon leiden (of de andere kant van de berg, zo je wilt..). Er is echter behoorlijk wat bestuurlijke moed nodig om de olietanker van enterpise IT ook echt te keren. Over bovenstaande richting van ICT en de bestuurlijke moed die hier voor nodig is heb ik diverse blogs geschreven.

Voor mezelf gaat het aan het eind van de dag wel om het resultaat en het zien dat jou ideeën in de praktijk ook echt werken. Ik wil niet blijven hangen in de productie van ideeën en bijbehorend papier. Dat geeft me namelijk ook niet de kans om te leren van de hersenspinsels en ‘op mijn bek te gaan’ 😉

Dankzij mijn blogs, whitepapers en presentaties over cloud en datacenter ontwikkeling, werd ik gevraagd om enkele andere grote Nederlandse ondernemingen te helpen in het vormen van een cloud strategie. Nadat ik zag wat dit voor organisaties kon betekenen zag ik een synchronisatie probleem ontstaan tussen mijn persoonlijke ontwikkeling en die van mijn eigen (overheids) organisatie…

OCOM en EvoSwitch ?

In 2009 ontmoete ik Eric Boonstra (MD EvoSwitch) toen ik een presentatie gaf over de opkomst en ontwikkeling van datacenter containers en het modulaire effect, op een datacenter congres. Zoals met vele andere organisaties had ik ook met Eric en zijn team een kennissessie om gezamenlijk te kijken naar de ontwikkelingen in de datacenter markt, die de afgelopen jaren een grote technische vlucht hebben genomen.

Het bezoek aan Eric bleef echter hangen in mijn hoofd. Ik zag hoe hij dacht over het verduurzamen van zijn datacenter operatie en de manier waarop hij de klant probeerde mee te nemen. Op dat vlak had ik al eerder in presentaties en blogs mijn kritiek geuit.

Opvallend was de reactie uit de zaal op bepaalde datacenter onderwerpen. Vooral omdat het grootste deel van het publiek geen datacenter eigenaar was, maar uit de leverancier/consultant hoek kwam. Je zou verwachten dat deze mensen op de hoogte zijn van de laatste technische en wettelijke ontwikkeling. Innovatie zou volop in beeld moeten zijn… en dat was het niet… Er waren zeer conservatieve geluiden te horen en mensen die aangaven ‘ja maar… we moeten toch 21C lucht aanbieden met een bepaalde luchtvochtigheid’.

Ik luisterde met verbazing, tot dat de datacenter collega … met zijn presentatie begon en de opmerking maakte ‘ik kan niet te ver afwijken en te ver gaan in de ASHRAE normen omdat de klanten daar niet om vragen..’

EvoSwitch ziet daarbij het groen zijn als een kans voor de klant en kijkt verder dan alleen de energie efficiëntie; namelijk naar de duurzaamheid van zijn product. Dit pas ook perfect in de trend in de markt zoals bij de ontwikkeling van The Green Grid. Als je dit echt goed wilt doen, heb je een holistische blik nodig en moet je bereid zijn te innoveren.

Later had ik de kans om met Con Zwinkels (MD moederbedrijf OCOM) hier over van gedachte te wisselen en dit gesprek een stap verder te nemen rond keten integratie. Dit is ook al een tijdje een stokpaardje van mij en mijn DatacenterPulse collega’s, zoals ik bijvoorbeeld beschreef rond ‘Groene’ applicaties.

Het aardige is dat OCOM hiertoe de mogelijkheid heeft vanuit de portfolio van bedrijven die tot de groep behoren. Met Leaseweb als een grote klant van EvoSwitch geeft dit de mogelijkheid tot eigen keten integratie tussen het facilitaire datacenter en de IT zijde. Deze kennis kan vervolgens mee genomen worden naar andere co-lo klanten.

Daarnaast zit er in het OCOM portfolio een interessante mix van bedrijven die Cloud hosting echt mogelijk maken; van de keten optimalisatie met EvoSwitch en Leaseweb, die nodig is voor bijvoorbeeld low-cost servers met hoge beschikbaarheid, tot aan de noodzakelijke CDN vanuit Fiberring. Ook is er veel kennis over het in de lucht houden van grote hoeveelheden systemen (30.000+ ). Dit alles sluit goed aan bij de kennis die ik zelf mee breng vanuit datacentra, cloud en hoge beschikbare IT omgevingen.

Ze zien daarbij ook de voordelen in kennisdeling in organisaties en platformen zoals The Green Grid. Dit past uitstekend bij het werk dat ik gedaan heb (en blijf doen) voor DatacenterPulse en bijvoorbeeld de NEN.

De afgelopen jaren ging het hard met OCOM en belande ze in de Deloitte Technology Fast50 (de lijst van snelst groeiende techbedrijven van Nederland). De ambitie is om de komende jaren uit te bouwen binnen Europa en de US. Een extra reden voor mij om voor deze organisatie te kiezen is het feit dat ze dit met een flexibele en platte organisatie doen. Hier door zijn de lijnen kort en ontstaat de mogelijkheid om snel te schakelen. Een hogere kans om mijn visies werkelijkheid te zien worden.

Kortom; voor mij de mogelijkheid om te bouwen en te innoveren op datacenter en cloud gebied.

Ik wil richting mijn overheidscollega’s de dank uit spreken voor de samenwerking de afgelopen jaren. In de zijlijn blijf ik verbonden met ICT voor de overheid en dan vooral de OOV sector; als vrijwillig brandweerman en dus als klant.

En datacenter innovatie… opgepast… want hier kom ik! 😉

(Misschien ten overvloede; bovenstaande blog is geschreven onder de volgende disclaimer. Alle informatie is publiekelijk toegankelijke kennis o.a. uit deze rapporten)

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

Gisteren ging een deel van de Amazon AWS dienst verlening plat. Amazon melde het volgende:

“A networking event early this morning triggered a large amount of re-mirroring of EBS volumes in US-EAST-1,” Amazon said in a status update just before 9 am Pacific time. “This re-mirroring created a shortage of capacity in one of the US-EAST-1 Availability Zones, which impacted new EBS volume creation as well as the pace with which we could re-mirror and recover affected EBS volumes. Additionally, one of our internal control planes for EBS has become inundated such that it’s difficult to create new EBS volumes and EBS backed instances.

De verstoring kwam kort gezegd neer op de uitval van 1 van de Amerikaanse beschikbaarheids zones. De overige zones draaide wel gewoon door. Als gevolg hier van waren ook enkele andere ‘cloud’ services (voornamelijk SAAS), die boven op AWS gebouwd zijn, uitgevallen. Een lijst hier van werd gepubliceerd op http://ec2disabled.com/

Al snel zagen we dat de cloud tegenstanders de mestvorken en knuppels uit de stal hadden gehaald… want ‘de cloud’ had eindelijk zijn ware aard laten zien… en had gefaald.

Dit gebeurde al eerder, zoals mijn DatacenterPulse collega Tim Crawford in zijn blog aanhaalt:

Ook bij deze uitval stonden mensen op de barricade te schreeuwen dat cloud niet betrouwbaar was. Voor leveranciers (en ICT-ers) waar voor de cloud ontwikkeling een bedreiging is (reëel of niet..), is dit een uitstekende gelegenheid om weer wat FUD rond te strooien. Deze tactiek haalde ik al eerder aan in mijn blog: Controle en Vertrouwen; sleutels voor cloud. Hierbij gaf ik ook aan dat het vertrouwen gemakkelijk geschaad word:

Het vertrouwen in cloud computing is iets wat gemakkelijk te schenden is. Het traditionele datacenter leeft redelijk ‘onder de radar’ als het gaat om uitval. Meestal raakt uitval daar slechts enkele applicaties of een deel van de business. Deze uitval kan wel degelijk een grote impact hebben op de productiviteit van een organisatie maar het zal nooit de mate van negatieve publiciteit krijgen die cloud providers ontvangen.

Een vliegtuig crash komt wel in het nieuws, maar de 1000-en auto ongelukken die zelfde dag meestal niet.

Opvallend was echter ook dat een aantal andere cloud services, waar van bekend is dat ze op AWS draaien, gewoon in de lucht waren. Grootste voorbeelden waren Netflix en Twilio.

Referentie architectuur…

In voorgaande blogs gaf ik ook al aan, dat cloud adoptie en migratie draait om de adoptie van een referentie architectuur van iemand ander. Je gaat aan de slag op een IAAS of PAAS omgeving die door iemand anders ontworpen en gebouwd is. Dit men hun visie en gedachte goed. Je moet je dus aan hun regels houden;

Het begrijpen van de referentie architectuur en ontwerp principes van je cloud leverancier is bijzonder belangrijk. Zowel bij IAAS, als bij PAAS geld dat je applicatie of omgeving ontworpen moet zijn voor deel-systeem uitval. Zoals in de PAAS serie aangegeven: ‘Cloud applications assume failure.’ Soms word dit ondervangen door de aangeboden frameworks, maar je moet dan wel begrijpen hoe deze werken.

Organisaties die niet geraakt werden door de AWS uitval begrepen de architectuur optimaal en hadden hun diensten bij ontwerp en bouw al verdeeld over meerdere geografische beschikbaarheids zones, zoals NetFlix in een presentatie (slide 32-35) eerder liet zien:

Verder zijn er diverse andere mogelijkheden om redundantie in te bouwen in een AWS omgeving. Zie diverse blogs met tips:

Systeem uitval is een dagelijkse realiteit. Rond cloud computing word vaak geroepen dat ‘cloud omgevingen niet kunnen uitvallen’. De realiteit is echter dat cloud infrastructuren ook kunnen uitvallen. Het verschil tussen cloud en traditionele infrastructuur is echter dat cloud nieuwe (technologische) mogelijkheden biedt voor redundantie en het herstarten van de dienstverlening als deze uitval plaats vind.

We moeten dus blijkbaar nog wel leren om gaan met deze nieuwe vormen van beschikbaarheid en disaster recovery (DR) 🙂